Останні два роки пов'язані з бурхливим розвитком технологій штучного інтелекту. Нейромережі навчилися генерувати осмислений текст, якісні зображення та навіть відео. І все це супроводжується неймовірним попитом на прискорювачі обчислень Nvidia, що підняло «зелену» корпорацію на вершину фінансового ринку. Але колись компанія була новачком в індустрії, і перші її починання мало не призвели до банкрутства. Історія Nvidia почалася з трьох друзів: колишнього інженера AMD Дженсена Хуанга (Jensen Huang), а також двох працівників Sun Microsystems — Кріса Малаховскі (Chris Malachowsky) та Кьортіса Према (Curtis Priem). Тридцять років тому, 1993 року, ці хлопці вирішили створити свою справу. Їхнє підприємство було не просто черговим IT-стартапом, а створювалося з прицілом на вузьку нішу комп'ютерної 3D-графіки.

Назва нової компанії була придумана прямо перед реєстрацією. Всі внутрішні файли та документація проходили під назвою NV, як скорочення від next version. Переглянувши латинські слова із цим сполученням літер, засновники обрали invidia («заздрість») і назвали майбутнього флагмана індустрії Nvidia.

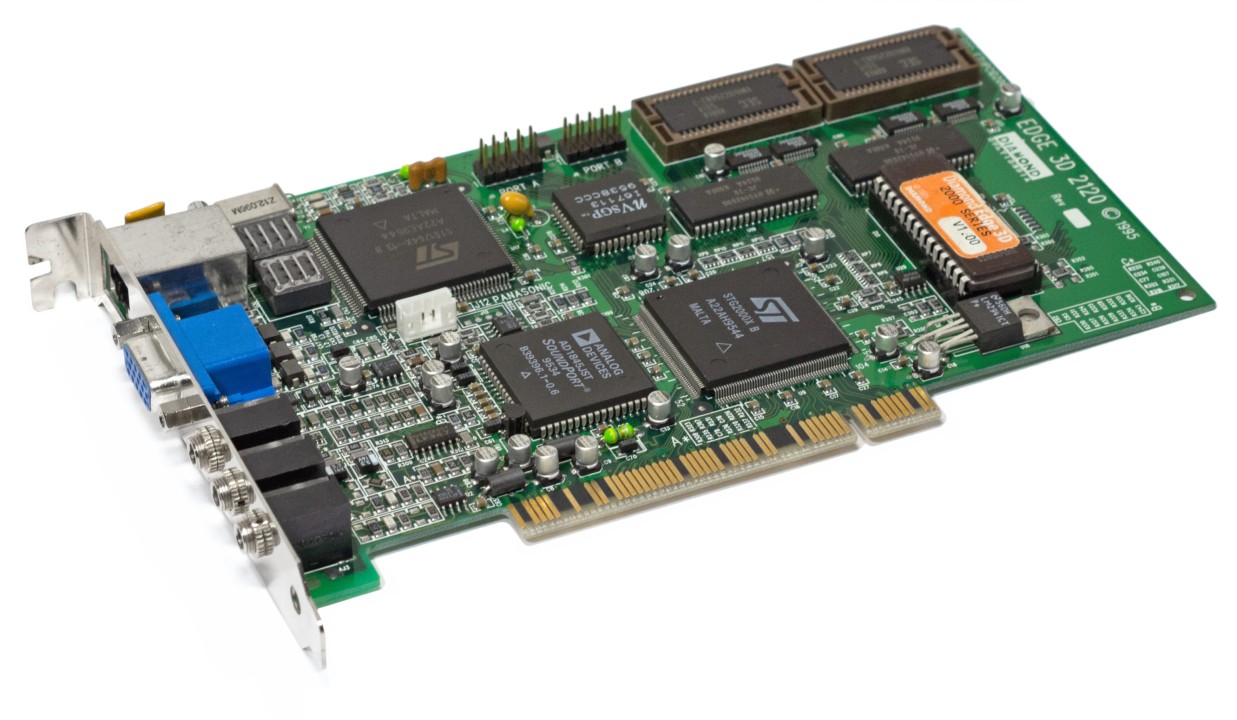

Спочатку молода команда не мала власних виробничих потужностей, тому Nvidia уклала контракт зі швейцарським виробником SGS-THOMSON (STMicroelectronics). У 1995 році, через два роки після початку роботи, Nvidia представила першу відеокарту для IBM PC-сумісних комп'ютерів під назвою NV1, яка являла собою комбайн із графічного адаптера та звукової карти з можливістю підключення геймпадів від приставки Sega Saturn. Новинка випереджала конкурентів в особі ATI, S3 та Matrox безпосередньо у 3D-графіці, але поступалася якістю двомірної графіки, а звук був гірший за зовнішні «саундбластери». Погіршила ситуацію презентація компанією Microsoft програмного інтерфейсу API DirectX 1.0 для створення тривимірних ігор. В його основі був полігональний рендеринг, тоді як Nvidia NV1 підтримувала квадратичний. Компанія схаменулась і в 1996 році реалізувала програмну підтримку DirectX. Але відеокарта виявилася слабшою за рішення конкурентів, які мали апаратну інтеграцію API від Microsoft.

Nvidia NV1 (фото Linkedin.com)

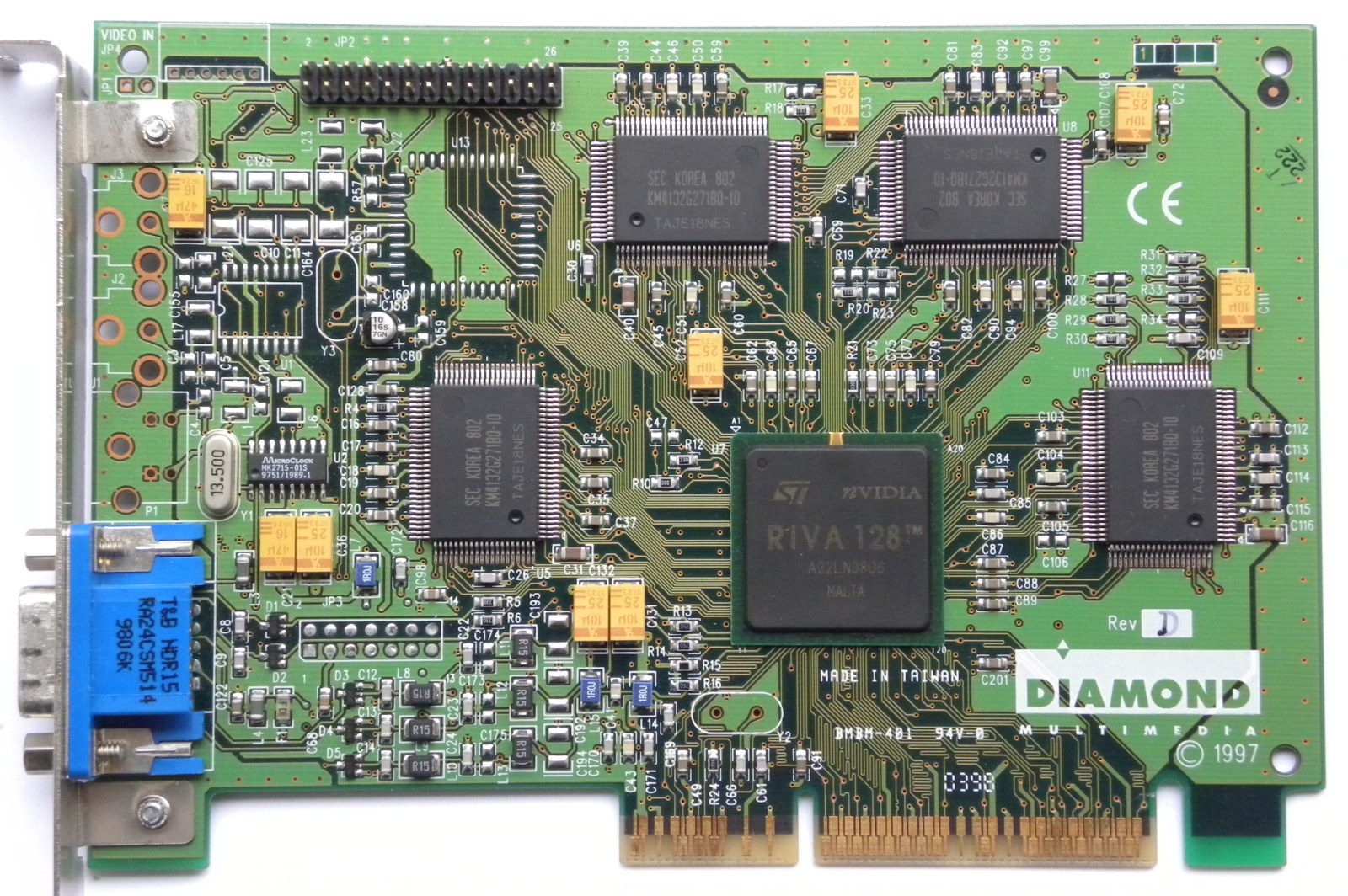

У 1997 році Nvidia представила Riva (Real-time Interactive Video and Animation accelerator) — серію відеокарт з інтерфейсом AGP та повноцінною підтримкою технологій OpenGL та DirectX. Однак новинки не працювали із закритим API Glide від тодішнього гіганта тривимірної графіки компанії 3dfx Interactive. За фактом це означало, що всі ігрові хіти того часу, наприклад Need for Speed II, не запускалися на відеокартах Riva з максимальними налаштуваннями графіки. Проте перші відеокарти Riva 128 використовували комбінований чип для графіки 2D/3D. Також було реалізовано уніфіковану архітектуру пам'яті. І користувачеві достатньо було одного пристрою замість двох прискорювачів для 2D та 3D, як це було з Voodoo Graphics.

Riva 128 з'явилася в період, коли компанія була за крок від банкрутства. Але цей пристрій виявився досить успішним, за чотири місяці було продано близько мільйона відеокарт, що врятувало Nvidia та забезпечило фінансами для подальших розробок.

Riva 128 (фото vgamuseum.info)

У 1998 році було представлено Riva TNT, яка отримала підтримку 32-бітового кольору, чого не було в інших виробників. Пізніше для відеокарти вийшли перші в історії драйвери Detonator з підтримкою технології 3DNow!, що серйозно покращило продуктивність на системах з процесорами AMD.

Популярність Riva допомогла Nvidia перебратися до легендарної Кремнієвої долини. Сталося це 1998 року. Нову штаб-квартиру заснували у місті Санта-Клара, штат Каліфорнія. Тоді ж Nvidia укладає контракт на постачання чипів із тайванським виробником Taiwan Semiconductor Manufacturing Company (TSMC).

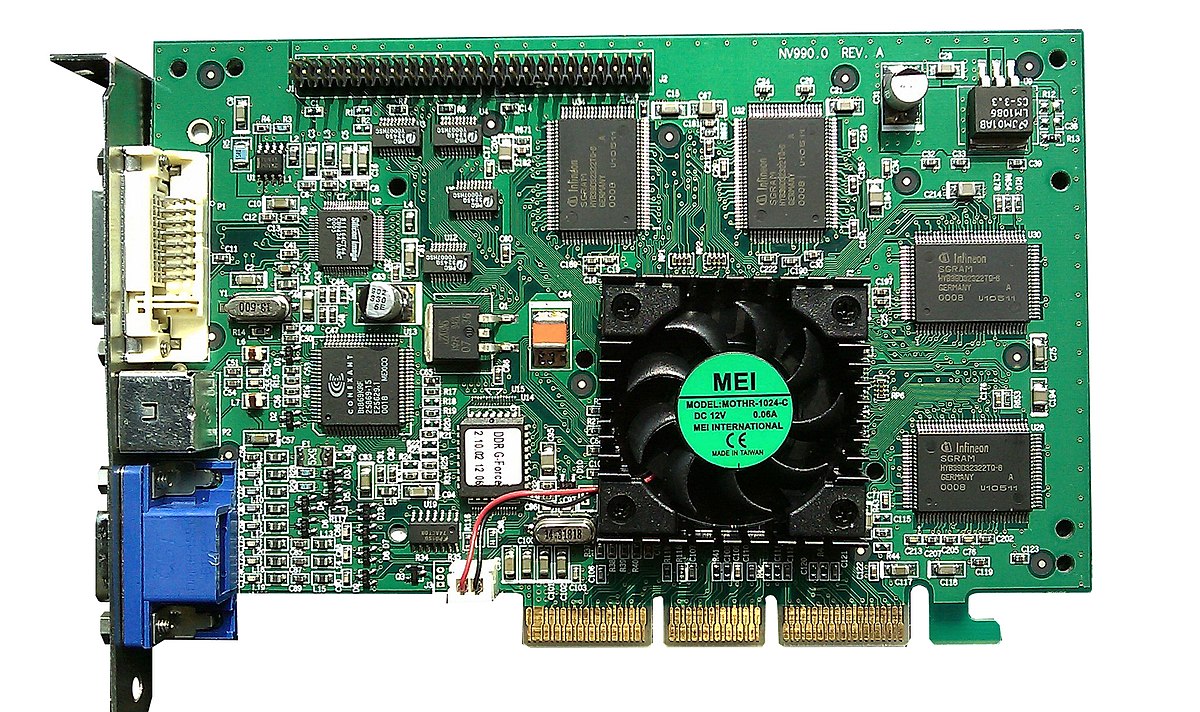

1999 став для компанії історично важливим і епічно успішним. Спочатку Nvidia представляє Riva TNT2, а потім оголошує про запуск серії продуктів GeForce і Quadro, розрахованих на масового та професійного споживачів.

Riva TNT2 (фото hw-museum.cz)

За цим ходом стояв грамотний маркетинговий задум, завдяки якому Nvidia могла використовувати однакові чипи одночасно в різних сегментах ринку. За фактом GeForce і Quadro були подібними продуктами. Але у масових споживчих відеокартах виробник просто блокував частину функцій.

Першим представником серії GeForce стала відеокарта GeForce 256, яку назвали першим у світі графічним процесором (GPU, Graphics Processing Unit). Пристрій використовував однокристальний чип із вбудованими механізмами трансформації, освітлення та налаштування/обрізання трикутників. Раніше частину цих операцій виконував CPU. Число «256» у назві вказує на чотири 64-бітові піксельні конвеєри в чипі NV10.

GeForce 256 (фото Wikipedia.org)

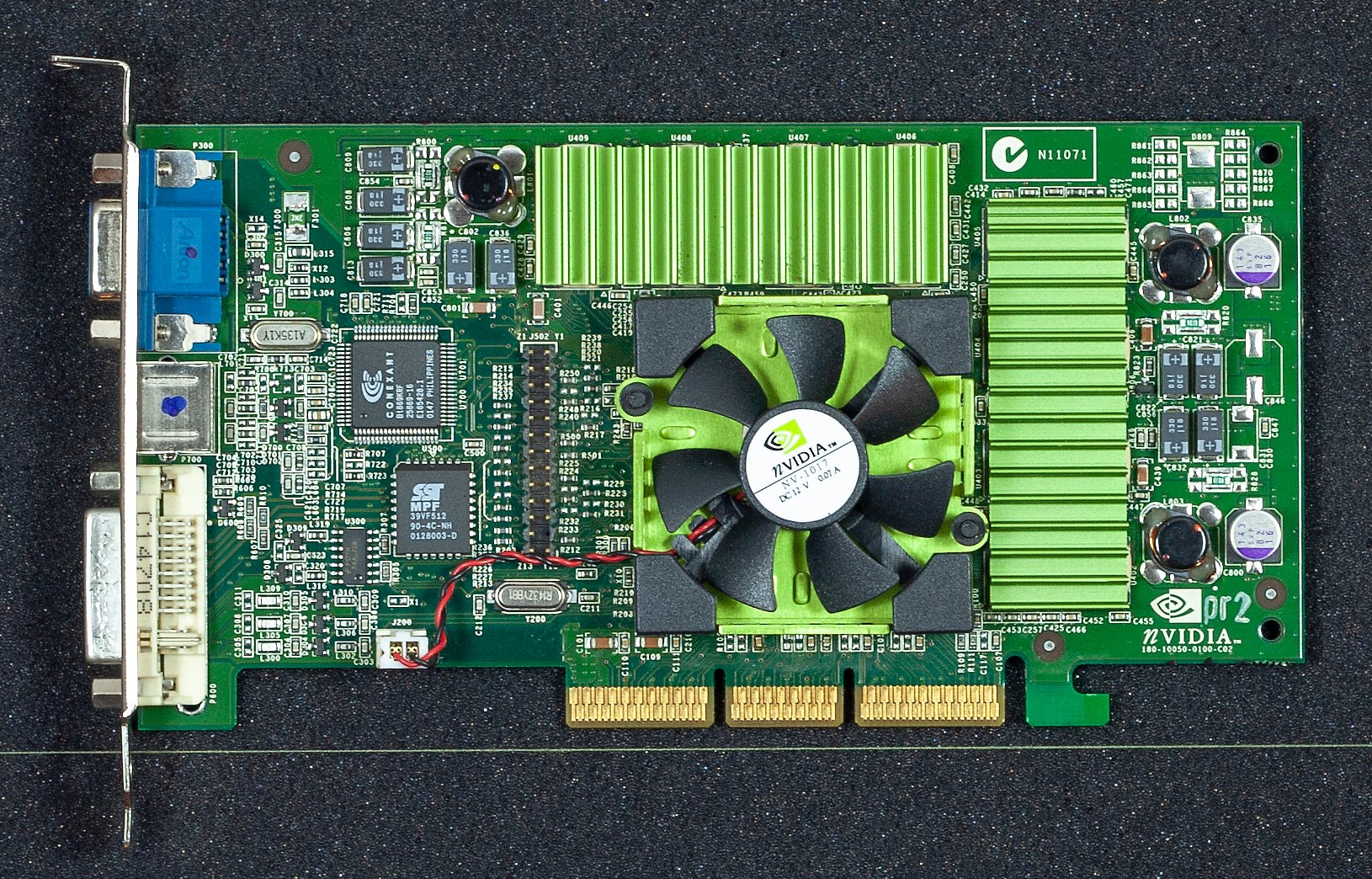

У 2000 році Nvidia представила серію відеокарт GeForce 2 і купила збанкрутілого конкурента 3dfx Interactive. Першою у новій лінійці стала GeForce 2 GTS. Завдяки швидшому чипу вона показувала перевагу в 40% відносно попередника і впевнено випереджала конкурентів у більшості режимів. Водночас виходить урізана версія GeForce 2 MX, яка разом зі своїми варіаціями стане справжнім бестселером на масовому ринку відеокарт. Пізніше з'явилася модель GeForce 2 Ultra з вищими частотами та пам'яттю DDR об'ємом до 64 МБ.

У 2001 році компанія випустила першу відеокарту для ноутбуків GeForce 2 Go та перший інтегрований графічний чип GeForce 2 MX IGP. Далі вийшли відеокарти GeForce 3 на базі процесора NV20. Ці рішення отримали покращені ефекти тіней і світла, апаратну підтримку вершинних та піксельних шейдерів. Поява шейдерів стала знаковою подією, надавши розробникам нові можливості для створення гарних візуальних ефектів.

GeForce 3 Ti 500 (фото collection.batyra.pl)

Того ж року у продаж надійшла ігрова консоль Xbox від Microsoft, яка використовувала покращений графічний чип NV20 (GeForce 3). Також консоль використовувала аудіосистему SoundStorm від Nvidia.

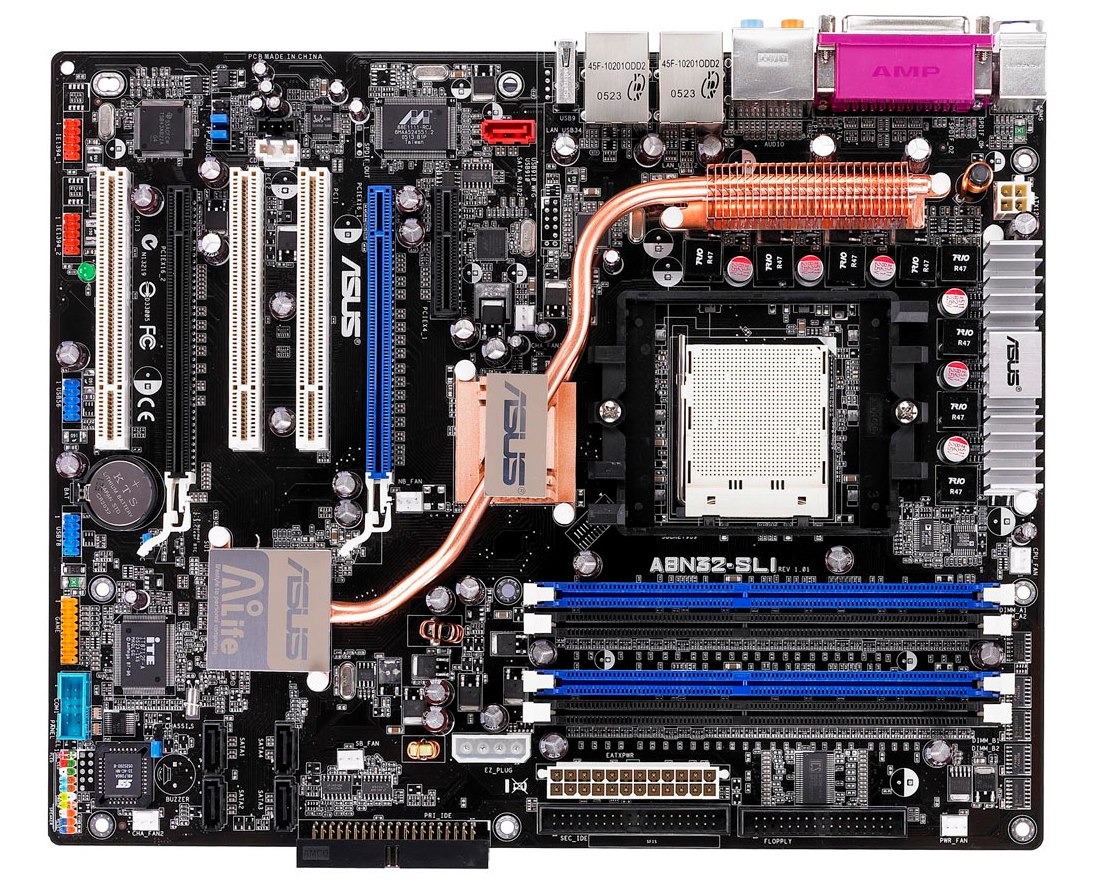

У 2001 році компанія розпочала експансію у новій сфері, випустивши чипсети nForce для платформи AMD. Підтримка двоканального режиму пам'яті, висока продуктивність та функціональність забезпечили лідерство і тут. Дуже швидко материнські плати на чипсетах nForce стали найкращим вибором для ентузіастів та геймерів, які хочуть отримати максимальну продуктивність від ПК із процесором Athlon XP.

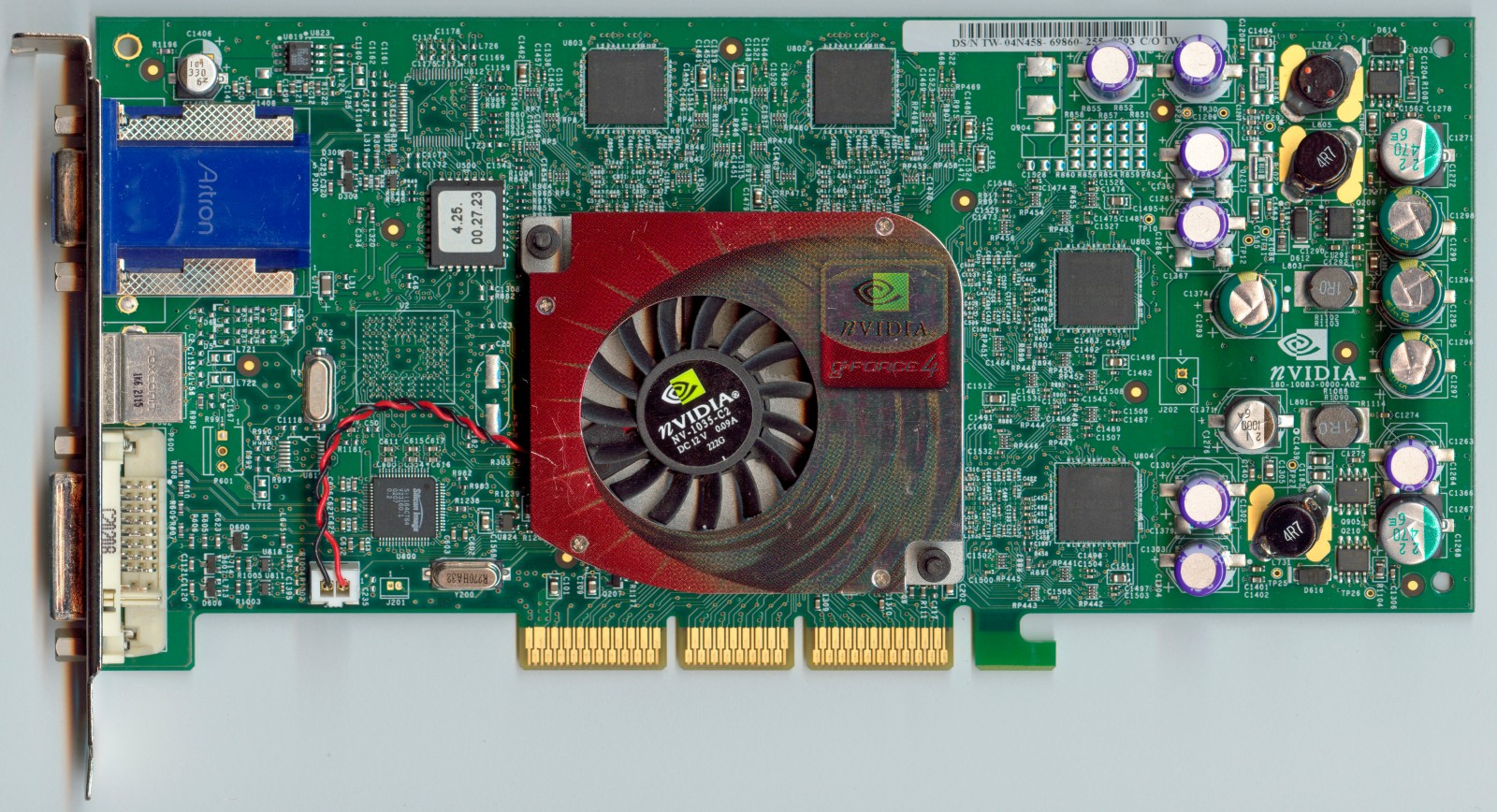

Але повернемося до відеокарт. У 2002 році вийшла лінійка GeForce 4. У цьому ж році Nvidia продала свою 100-мільйонну відеокарту та отримала звання кращої компанії за темпами розвитку у США, за версією журналу Fortune.

GeForce 4 Ti 4600 (фото hw-museum.cz)

В основі серії GeForce 4 був доопрацьований чип NV25, а пізніше NV28 з нативною підтримкою AGP 8x. Основна відмінність була у додатковому блоці вершинних шейдерів, у підвищених частотах та покращеному контролері пам'яті. Першими стали GeForce 4 Ti 4400 та топова Ti 4600. А оптимальним вибором для оверклокерів була GeForce 4 Ti 4200, яка працювала на знижених частотах, але це можна було легко виправити.

Після представлення бюджетної лінійки з індексом MX компанія вирішила і надалі випускати пристрої такого рівня. Відеокарти були урізані за кількістю піксельних конвеєрів й не підтримували шейдери. Але завдяки ціні вони мали великий попит на нашому ринку. Різні варіації GeForce 4 MX нарівні з GeForce 2 MX протягом кількох років були наймасовішими відеокартами у ПК українського школяра чи студента.

Також 2002 рік ознаменувався появою перших ігор з шейдерними ефектами. І власники відеокарт GeForce могли насолодитися неймовірною для того часу водою у The Elder Scrolls III: Morrowind.

У 2003 році компанія представила лінійку відеокарт GeForce FX 5000. Сімейство стартувало з топової відеокарти GeForce FX 5800, яка використовувала GPU NV30 і пам'ять GDDR2 зі 128-бітною шиною, що на тлі конкурента виглядало посередньо. Потім з'явилися простіші моделі GeForce FX 5600/5200, але вони не показали помітного зростання швидкодії відносно попередників. В цілому серія вийшла не дуже вдалою, тому Nvidia почала нарощувати частоти, і вершиною такої стратегії стала GeForce FX 5950 Ultra із шиною пам'яті 256 біт.

У 2004 році вийшла серія GeForce 6000, яка пропонувала повну апаратну підтримку DirectX 9.0c та Shader Model 3.0. Також нове покоління забезпечили технологією Nvidia SLI та нативною підтримкою PCI Express. Топовий сегмент був представлений різними варіантами GeForce 6800 (до Ultra-версії). У «народному» сегменті особливу популярність здобула серія GeForce 6600/6600GT. Вони забезпечили відмінне поєднання ціни та продуктивності, дозволяючи грати у всі актуальні ігри з досить високими налаштуваннями графіки.

GeForce 6800 Ultra

Цей рік був багатим на технологічні гарні ігри, що викликали захоплення графічним рівнем виконання. Це Half-Life 2, Far Cry, Doom 3, The Chronicles of Riddick, Splinter Cell: Pandora Tomorrow, Need for Speed Underground 2, Medal of Honor: Pacific Assault. Отож причин для апгрейду та придбання нових відеокарт в той час було достатньо.

Half-Life 2

Наступного року було запущено серію GeForce 7000, яка стала розвитком минулої архітектури з поступовим нарощуванням обчислювальних блоків. Спочатку був представлений графічний прискорювач GeForce 7800 GTX, а через рік вийшли різні версії GeForce 7900 на доопрацьованому ядрі GV71.

У 2005 році компанія купила розробника системної логіки ULi Electronics (ALi Corporation у минулому), який випускав чипсети для платформи AMD. Цікаво, що ULi була партнером ATI. Але й на червоного конкурента чекала непроста доля — 2006 року компанію поглинув процесорний гігант AMD. Покупка ULi допомогла Nvidia зміцнити свої позиції у сфері системної логіки як для AMD, так і для Intel. Цей напрямок розвивався досить успішно, але в якийсь момент виникли проблеми з ліцензуванням, AMD та Intel хотіли особисто випускати системну логіку для своїх платформ. Тому у 2008 році Nvidia закрила цей напрямок бізнесу.

Материнська плата ASUS A8N32-SLI Deluxe (nForce4 SLI X16)

Починається партнерство Nvidia та Sony для створення нової консолі PlayStation 3. Спеціально для приставки розроблено графічний процесор Nvidia RSX, в основі якого модернізована версія чипа NV47 (GeForce 7800 GTX), плюс 256 МБ відеопам'яті GDDR3. PlayStation 3 надійде у продаж у 2006 році. Цікаво, що при розробці наступного покоління вибір буде зроблено на користь конкурента — PlayStation 4 (як і Xbox One) перейде на платформу AMD.

У 2006 році Nvidia продовжила доповнювати лінійку 7000 серії, представивши моделі GeForce 7600 для середнього класу і GeForce 7900 для старшого сегмента. Вершиною розвитку серії стала двочипова модель GeForce 7950 GX2. Цей «монстр» поєднував дві плати з парою GPU G71, кожен мав 512 МБ пам'яті GDDR3 на 256-бітній шині. По суті це SLI-тандем із двох GeForce 7900 у форматі одного пристрою. І такі відеокарти можна було поєднати разом, отримавши конфігурацію Quad SLI з чотирьох графічних прискорювачів.

GeForce 7950 GX2

У листопаді 2006 року були представлені відеокарти GeForce 8800 GTX та GeForce 8800 GTS на процесорі G80 — перші рішення з підтримкою API DirectX 10 та Shader Model 4.0. Новий API вимагав переходу на уніфіковану шейдерну архітектуру, яка дозволяла гнучко керувати обчислювальними ресурсами. Графічний процесор G80 отримав 128 універсальних блоків та вперше 384-бітну шину. Максимальну продуктивність пропонувала відеокарта GeForce 8800 GTX з 768 МБ відеопам'яті, GTS-версія була трохи урізана та отримала 640 МБ пам'яті. Через пів року було представлено розігнану версію GeForce 8800 Ultra.

MSI GeForce 8800 Ultra (фото vgamuseum.info)

У 2007 році на ринок вийшли доступніші моделі серії GeForce 8000. «Народний» сегмент зайняли GeForce 8600 GT та GeForce 8600 GS. У середній ціновій категорії була випущена GeForce 8800 GT — надзвичайно вдала за поєднанням характеристик модель. В основі цієї відеокарти був процесор G92, який пізніше використовувався у продуктах наступного покоління.

Цей рік також ознаменувався запуском програмно-апаратної платформи Compute Unified Device Architecture (CUDA) для паралельних обчислень. Це дозволило ефективно виконувати загальні обчислення на GPU. В основі CUDA мова C, але також підтримуються C++, Fortran, пізніше було додано Python та інші сучасні високорівневі мови програмування. Nvidia активно підтримувала та розвивала CUDA, заклавши основи для подальшого успіху GPU у паралельних обчисленнях та обчисленнях штучного інтелекту.

Спеціально для нової сфери застосування у 2007 році було запущено прискорювачі Nvidia Tesla. В основі перших пристроїв були стандартні GPU G80, але без роз'ємів для виведення зображення. Такі обчислювальні прискорювачі зайняли місце додаткового співпроцесора в системах обробки великих обсягів даних і для паралельних обчислень.

Tesla C870 (фото Videocardz.com)

Наступна серія GeForce 9000 використовувала старі GPU, але помітно наростила робочі частоти. Відкрив нове покоління відеоадаптер GeForce 9800 GTX на знайомому чипі G92. Пізніше вийшла швидша версія з ще більшими частотами під назвою GeForce 9800 GTX+, яка через рік перетворилася на GeForce GTS 250. У нас навіть був огляд з порівнянням всіх цих однотипних моделей. Відеокарта GeForce 8800 GT після прискорення та оновлення стала GeForce 9800 GT. У найдешевшому сегменті з'явилася вдала GeForce 9600 GT. Не обійшлося без двоголового монстра у вигляді GeForce 9800 GX2. Це був бутерброд із двох GeForce 9800 GTX на окремих платах, об'єднаних в одному корпусі та з єдиною системою охолодження.

MSI GeForce 9800 GTX+

Одночасно Nvidia запускає сімейство графічних процесорів GRID спеціально для «хмарних» ігор. Основне завдання таких пристроїв — обробка графіки та потокова передача відео. Починається активне використання Nvidia Tesla, які встановлюються у великі суперкомп'ютери. І вже у 2010 році три з п'яти найпотужніших суперкомп'ютерів були оснащені прискорювачами Tesla.

У цьому ж 2008 році Nvidia поглинула компанію Ageia, яка розробляла фізичний рушій PhysX. Він призначався для відеоігор та симулював фізичні ефекти у режимі реального часу. Компанія впровадила напрацювання купленого стартапу та представила технологію Nvidia PhysX, на базі якої реалізовано низку фізичних ефектів.

PhysX додавав різні уламки, фізику рідини та ефекти для окремих елементів навколишнього середовища. Технологія активно використовувалася у всіх іграх серії Batman: Arkham, Borderlands 2, Mafia 2, Sacred 2 і деяких інших хітах.

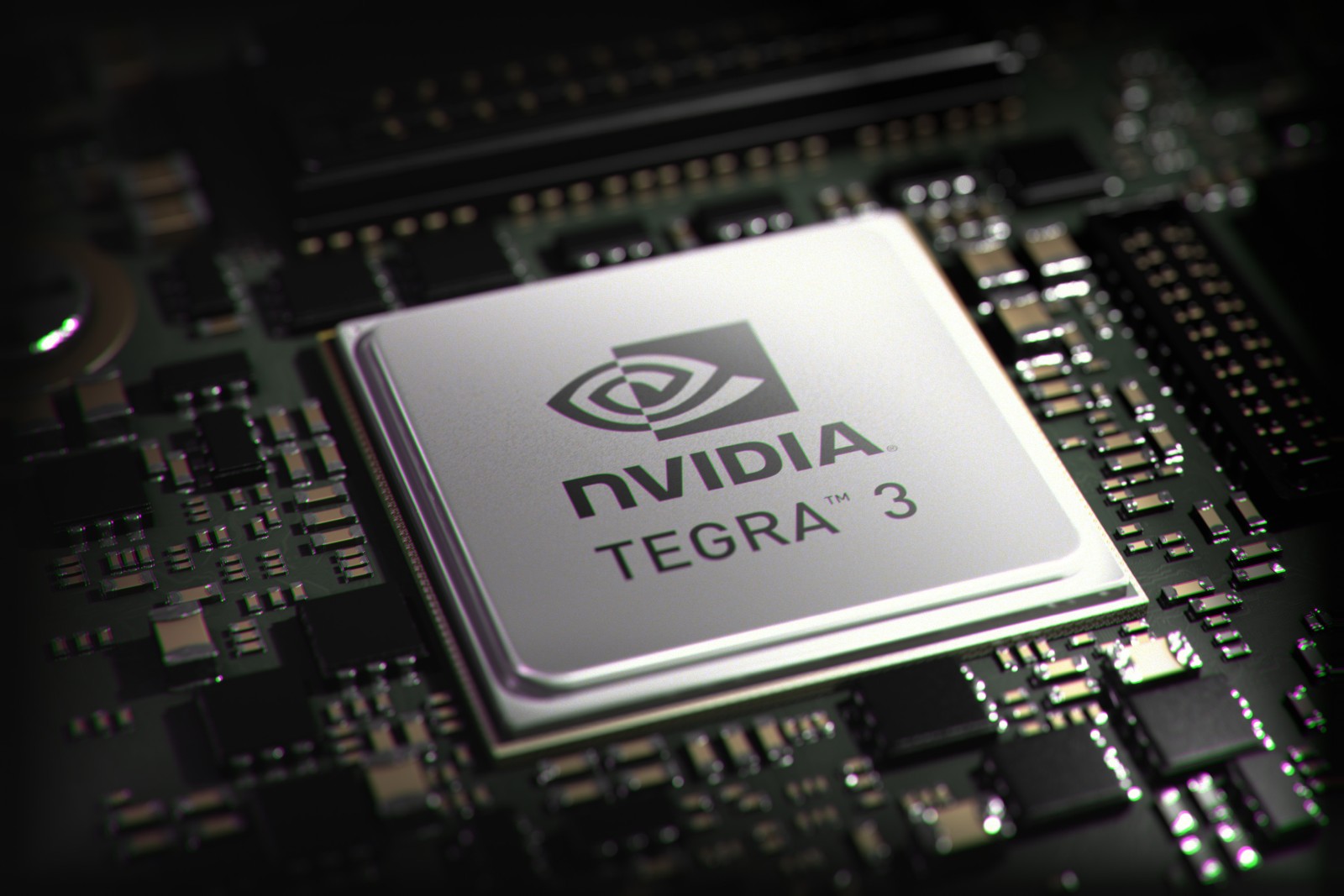

Також компанія випускає перший ARM-процесор Nvidia Tegra для мобільних систем. Цей SoC був заявлений для пари смартфонів від невідомих компаній, але також застосовувався в медіаплеєрі Microsoft Zune HD.

У другій половині 2008 року дебютувала серія GeForce GTX 200 на чолі з GeForce GTX 280. Флагман непогано конкурував навіть із GeForce 9800 GX2, але був дуже гарячим. Тому пізніше, у 2009 році, з'явилася GeForce GTX 285 на тонкішому техпроцесі з підвищеними частотами. Була в цьому поколінні своя двочипова відеокарта GeForce GTX 295, яка пропонувала тандем GeForce GTX 275 в одному пристрої. Перша ревізія двоголового монстра вийшла у вигляді двоплатної моделі, а пізніше з'явилася версія із двома чипами на одній PCB.

Inno3D GeForce GTX 285

Водночас набирає популярності тема 3D, а після виходу фільму «Аватар» у 2009 році почнеться справжній бум. Компанія у 2008 році анонсує власну технологію Nvidia 3D Vision. Для неї потрібні спеціальні окуляри с затвором, сумісний монітор із частотою 120 Гц та відповідний контент. На той час це був найпередовіший метод побудови 3D-зображення, але вкрай ресурсозатратний, а також була потрібна оптимізація кожної гри під такий режим.

Бум на 3D тривав кілька років, після чого споживачі швидко втратили інтерес до технології. Тому у 2019 році підтримку Nvidia 3D Vision було згорнуто.

Після двохсотої серії GeForce компанія у 2009 році випустила кілька моделей GeForce 100 і GeForce 300 для OEM-ринку. На якийсь час Nvidia навіть втратила ініціативу, і AMD першою представила відеокарти Radeon HD 5000 з підтримкою нового API DirectX 11. І лише у 2010 році вийшло нове повноцінне покоління GeForce GTX на архітектурі Fermi, яка заклала основи для подальшого розвитку GPU Nvidia на кілька поколінь уперед. Перший чип Fermi GF100 був виконаний по 40-нм техпроцесу та вийшов надзвичайно складним й гарячим. Тому його довелося трохи урізати навіть для флагманського відеоадаптера GeForce GTX 480. І сам GeForce GTX 480 запам'ятався не чудовою продуктивністю, яку він показував, а гарячим характером та шумом. Це саме та відеокарта, на якій колись смажили яйце, і читачі, можливо, пам'ятають цей ролик із далекого минулого.

Zotac GeForce GTX 480

Nvidia почала виправляти помилки й до кінця 2010 року випустила нове покоління на доопрацьованому і холоднішому чипі GF110. Відеокарти GeForce GTX 580 і GeForce GTX 570 виглядали привабливішими за сукупністю споживчих характеристик. А за ними пішли бюджетні рішення лінійки GeForce GTX 560 Ti, GeForce GTX 560 і GTX 550 Ti. Це відеокарти, на яких ми грали в Battlefield 3, The Witcher 2: Assassins of Kings та The Elder Scrolls V: Skyrim.

Не можна не відзначити вихід двочипового прискорювача GeForce GTX 590. На той момент це здавалося складним інженерним завданням, але Nvidia змогла об'єднати в рамках одного пристрою два потужних чипи.

ASUS GeForce GTX 590

У 2011 році компанія відсвяткувала мільярд проданих відеокарт і показала Nvidia Tegra 2 — свій перший 2-ядерний мобільний процесор. На відміну від попередника, новинка з'явилася у багатьох популярних пристроях, включаючи смартфон LG Optimus 2X, планшети ASUS Eee Pad Transformer TF101 та Samsung Galaxy Tab 10.1.

2012 приніс компанії новий рекорд — суперкомп'ютер Titan на відеокартах Nvidia Tesla став найпотужнішим пристроєм серед усіх конкурентів у рейтингу Top500. На той момент Titan складався з 18688 вузлів на базі 16-ядерних процесорів AMD Opteron 6274 у поєднанні з прискорювачами Tesla K20. Пікова продуктивність цієї системи перевищувала 27 петафлопс.

Цього ж року вийшла серія відеокарт GeForce 600 на новій архітектурі Kepler. Це розвиток Fermi з певними доопрацюваннями та реорганізацією внутрішньої структури. Старші GPU серйозно наростили кількість потокових процесорів, причому всі блоки повернулися до єдиної частоти, без прискорення шейдерного домену. Впроваджено технологію GPU Boost, що дозволяє гнучко регулювати робочі частоти GPU в рамках заданих лімітів потужності та температури. Топовий чип GK104 був обмежений шиною пам'яті 256 біт замість шини 384 біт у GF110/GF100, але це компенсувалося застосуванням швидшої пам'яті GDDR5. Серія стартувала з GeForce GTX 680, а трохи пізніше з'явилася двочипова версія GeForce GTX 690. У середньому сегменті було представлено GeForce GTX 670/660.

GeForce GTX 690

У лінійці ARM-процесорів з'явилася вже Tegra 3. Ці SoC знайшли застосування у широкому списку пристроїв від провідних виробників, включаючи Microsoft Surface, Google Nexus 7, HTC One X та багатьох інших.

У 2013 Nvidia випустила лінійку відеокарт GeForce 700. Частина продуктів серії вийшли на архітектурі Kepler, а частина на свіжій архітектурі Maxwell. Для найзапекліших і дуже багатих геймерів компанія випустила GeForce GTX TITAN — ігрову відеокарту з максимальними характеристиками, відкривши клас преміальних пристроїв.

GeForce GTX Titan

Проте лідерство TITAN тривало недовго. Незабаром після нього компанія випустила GeForce GTX 780 Ti на аналогічному GPU GK110 зі схожою швидкодією.

Nvidia почала активно розвивати нові технології синхронізації зображення. Спочатку з'явився метод Adaptive VSync, пізніше було представлено технологію Nvidia G-Sync. Другий метод вимагав спеціального модуля у моніторі, що різко підвищувало вартість відповідних пристроїв.

Відеокарти Kepler отримали можливість захоплення відео з апаратним кодуванням у реальному часі. Це дозволило записувати ігровий процес без зниження продуктивності. Функція ShadowPlay стала частиною програмного комплексу Nvidia Experience, де згодом стали з'являтися й інші корисні функції.

Паралельно компанія активно розвиває напрямок мобільних процесорів, випускає Tegra 4 та Tegra 4i. Останній навіть забезпечили LTE-модемом. Чип Tegra 4 став основним для портативної ігрової консолі Shield Portable. Завдяки потужній вбудованій графіці це був найкращий пристрій під Android-ігри. Приставка виглядала досить оригінально — великий геймпад з відкидним 5-дюймовим екраном роздільною здатністю 720p.

У 2014 році компанія запустила нову серію GeForce 900 на базі енергоефективної архітектури Maxwell, що забезпечило найкращу економічність у поєднанні з підвищенням продуктивності. Завдяки переробленій структурі всередині GPU вдалося розмістити більше мультипроцесорів. Спочатку компанія обкатала Maxwell на бюджетній відеокарті GeForce GTX 750 Ti, а згодом представила GeForce GTX 980 та GeForce GTX 970. Через деякий час, у 2015 році, вийшла потужніша відеокарта GeForce 980 Ti.

GeForce GTX 980 Ti

GeForce GTX 970 набула великої популярності в середньому ціновому сегменті, але з нею пов'язаний невеликий скандал. Через урізану шину робота з пам'яттю організована так, що 3,5 ГБ працювали при повній пропускній здатності, а останній сегмент 0,5 ГБ працював помітно повільніше. За фактом відеокарта ефективно працювала лише з 3,5 ГБ, і ця технічна особливість до певного моменту замовчувалась.

Цього ж року представлений новий мобільний чип Nvidia Tegra K1. Новинку встановили в перший ігровий планшет компанії Shield Tablet.

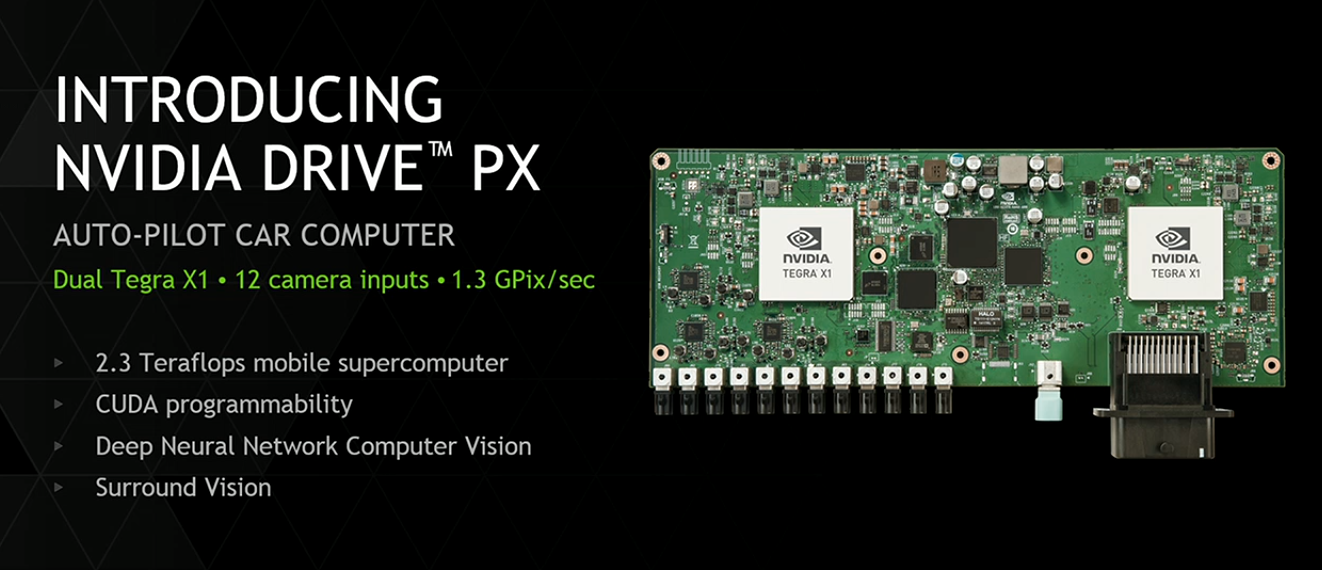

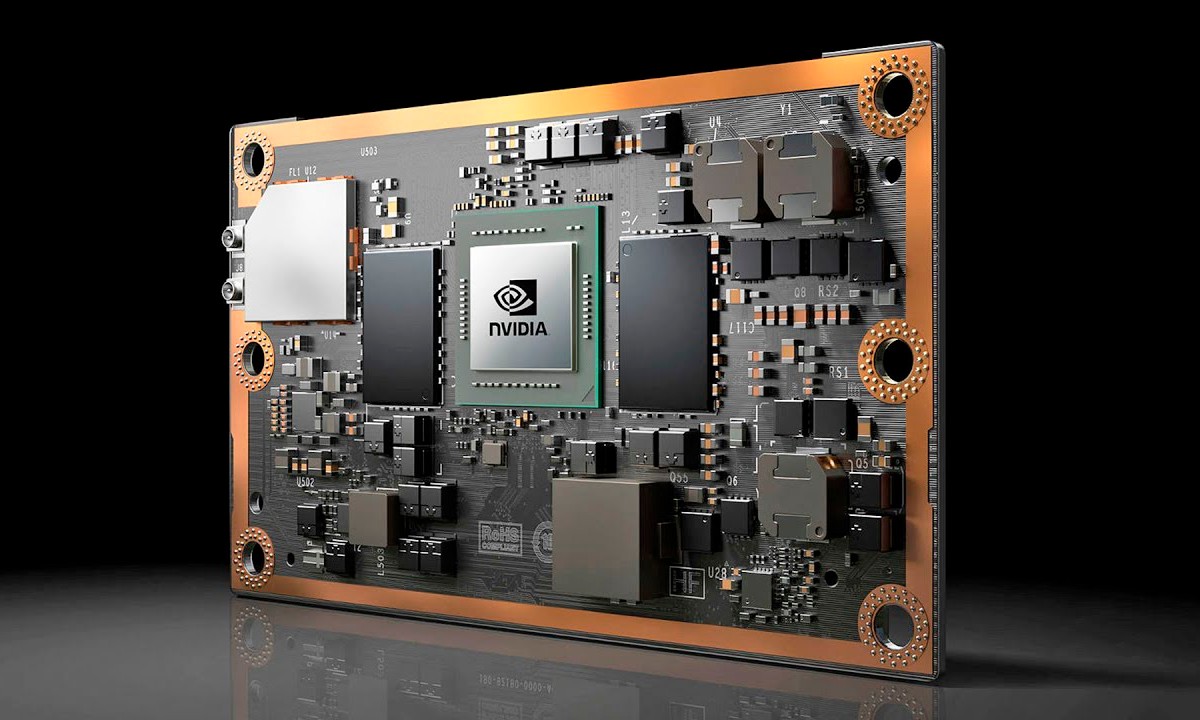

Nvidia починає активно розвивати технології на базі нейронних мереж та глибокого навчання, створюючи апаратні рішення для нових напрямків. У 2015 році запущено платформу Nvidia DRIVE для автомобільних систем на основі ШІ. Перші апаратні продукти були побудовані на Nvidia Tegra X1 — потужний чип з 8 ARM-ядрами та вбудованим GPU архітектури Maxwell з 256 ядрами. Також у 2015 році Nvidia випустила Jetson TX1 — модульний комп'ютер для роботизованих систем.

У 2016 році Nvidia показала нове сімейство графічних процесорів GeForce 10. Усі відеокарти цієї серії засновані на архітектурі Pascal, яка стала розвитком Maxwell із безліччю покращень. Це зокрема, ефективніші методи стиснення даних у буфері кадру, що забезпечує високу ефективність роботи з пам'яттю. Заодно Pascal перейшли на новий техпроцес 16 нм, що в поєднанні з більшою кількістю обчислювальних блоків забезпечило значне зростання продуктивності відносно минулого покоління. Відеокарти вийшли настільки вдалими, що моделі цього покоління досі працюють у багатьох користувачів. Серія стартувала з виходом GeForce GTX 1080, а трохи пізніше вийшли GeForce GTX 1070 та GeForce GTX 1060. Остання стала справжнім хітом і на багато років отримала статус «народної» відеокарти. 2017 став роком розвитку Pascal. Максимальну продуктивність у рамках цього сімейства забезпечили випущені GeForce GTX 1080 Ti, а також преміальні моделі сімейства TITAN.

GeForce GTX 1080

З запуском Pascal у 2016 році були представлені нові спеціалізовані прискорювачі Tesla P100 та серверні системи DGX-1 для глибокого навчання та прискорення штучного інтелекту. Одна система DGX-1 включала вісім пристроїв Tesla P100.

Бурхливо розвивається ринок VR, на той час вже були гарнітури HTC Vive, Oculus Rift CV1 та багато інших пристроїв. У Pascal реалізовано низку технологій та програмних оптимізацій для прискорення рендерингу у VR-режимі. Тоді ж представлено платформу Nvidia Iray VR для створення фотореалістичного зображення у віртуальній реальності із застосуванням трасування променів.

Епоха Pascal збіглася з майнінг-бумом, який почався на тлі зростання Bitcoin та запуску Ethereum. Майнери скуповували будь-які відеокарти, що призвело до серйозної кризи та дефіциту. Все це тривало до обвалу курсів криптовалют у 2018 році.

2017 став роком нової архітектури Nvidia Volta. Це перша самостійна розробка Nvidia для потужних суперкомп'ютерів та обчислень ШІ. Дана архітектура використовувалася тільки для прискорювачів Nvidia Tesla V100 на базі процесора GV100 з 5120 обчислювальними ядрами CUDA (що тоді здавалося неймовірним) та із застосуванням найшвидшої та передової пам'яті HBM2, яка розташовувалась на одній підкладці з основним кристалом GPU. У Volta GV100 вперше з'явилися спеціалізовані тензорні блоки для прискорення специфічних операцій, пов'язаних із ШІ.

Nvidia Tesla V100

Volta знайшла застосування тільки в високопродуктивних обчислювальних системах. Хоча на цьому чипі була ще преміальна відеокарта TITAN V, але вона вийшла обмеженим тиражем і мала неймовірний цінник у 3000 доларів. Сама архітектура Volta стала переломним етапом і ознаменувала поступовий ухил в оптимізацію GPU для операцій, пов'язаних із машинним навчанням нейромереж, що забезпечить у майбутньому бум штучного інтелекту.

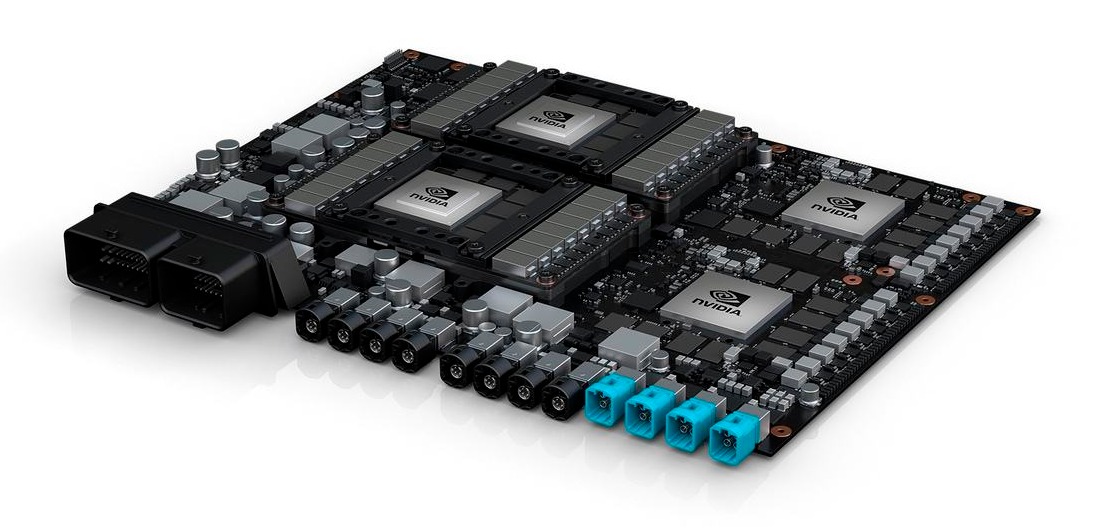

Також Volta знайшла застосування в суперкомп'ютері Drive PX Pegasus для автономних транспортних засобів. Це гібридний пристрій з двома SoC Tegra Xavier і двома GPU Volta.

Було випущено новий мініатюрний модульний суперкомп'ютер Nvidia Jetson TX2. Його призначення — створення роботів, дронів та камер зі штучним інтелектом для роботи у «розумних» містах майбутнього. У цьому йому допомагав віртуальний імітатор Nvidia Isaac. Новинка покликана спростити створення роботів з ШІ.

У 2017 році побачила світ нова версія телевізійної приставки Nvidia Shield TV. Це оновлений варіант раніше випущеної Shield Android TV, але у новому дизайні та з новими функціями. Консоль мала змогу забезпечувати стрімінг ігрового та відеоконтенту з підтримкою HDR та 4K.

Пристрої Shield дали поштовх розвитку стрімінгових технологій. Частиною їх можливостей був хмарний сервіс GeForce Now, який тепер дозволяє грати на будь-якому пристрої, запускаючи ігри на серверах Nvidia. З таким сервісом ви можете грати на слабкому ПК або на мобільному пристрої. GeForce Now тривалий час обкатували у бета-режимі, а офіційно сервіс був запущений лише 2020 року.

Також 2017 рік пов'язаний із запуском ще одного цікавого пристрою. Це портативна консоль Nintendo Switch, яку можна носити із собою або використовувати вдома у стаціонарному режимі. І мобільний процесор Nvidia Tegra X1 був найкращим вибором під такі завдання.

У серпні 2018 року виробник представив нову лінійку відеокарт GeForce RTX 20 (RTX 2000) на архітектурі Turing. Вперше за довгий час змінилася система найменувань, Nvidia відмовилася від абревіатури GTX заради назви RTX, яка натякала на підтримку технології Ray Tracing. Для цього нові GPU отримали спеціальні блоки, які прискорювали апаратне трасування. Це не означало повну відмову від растеризації, просто нові GPU могли підтримувати гібридний рендеринг, де трасування використовувалося для деяких ефектів.

Новий ігровий флагман GeForce RTX 2080 Ti вражав своїми можливостями та ціною. Хоча в чомусь він випередив час, і власники цієї відеокарти досі можуть комфортно грати у нові проєкти за невисокої роздільної здатності. Першою грою з трасуванням став шутер Battlefield V, потім були й інші. Але по-справжньому здивувати графікою змогли Metro Exodus та Control, які вийшли у 2019 році.

Також Turing отримали покращені тензорні блоки для обчислень ШІ та підтримку нової технології DLSS (Deep Learning Super Sampling) — просунуте масштабування на основі алгоритмів глибокого навчання. Компанія спромоглася першою адаптувати нові технології ШІ для споживчого сегмента. DLSS став ще однією революцією у 3D-графіці. І хоча перша реалізація була посередньою і робила картинку «мильною», вже із запуском DLSS 2.0 ситуація різко змінилася на краще.

У 2020 році компанія запустила серію відеокарт GeForce RTX 30. В основі серії архітектура Ampere, яка розвивала переваги Turing та нарощувала обчислювальний потенціал ядер RT та тензорних ядер. Для споживача це покоління стало ще дорожчим, рекомендована ціна на флагман GeForce RTX 3090 становила рекордні 1599 доларів. Також нове покоління вийшло в період чергового майнінг-буму та зльоту Ethereum, що погіршувало ситуацію з цінами та доступністю. Це змусило Nvidia реалізувати апаратний захист від майнінгу, і у 2021 році з'явилися відеокарти з приставкою LHR (Lite Hash Rate).

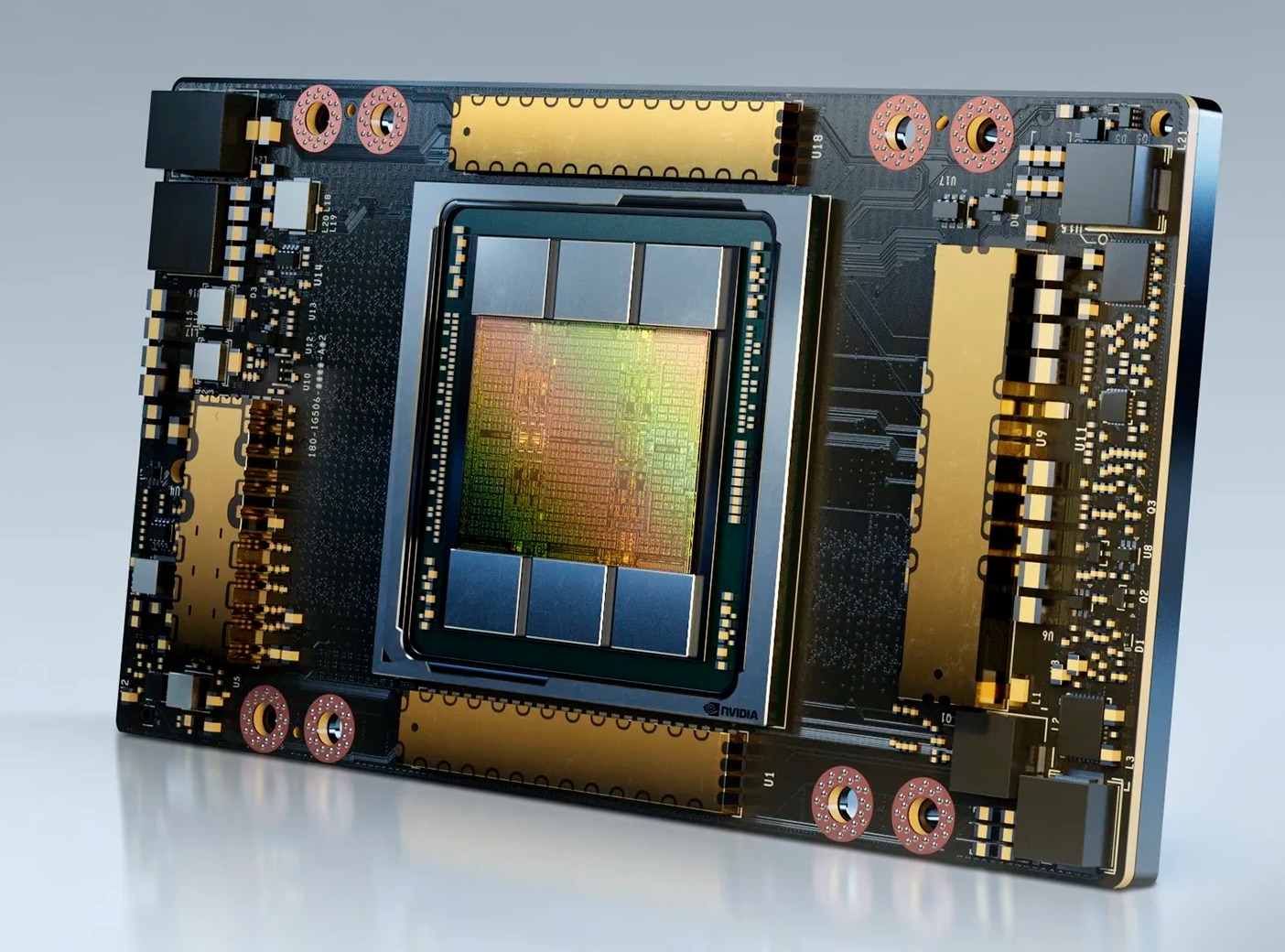

Якщо Turing був орієнтований на споживчий сегмент, і на цій архітектурі вийшов один прискорювач обчислень Tesla T4, то архітектура Ampere є універсальною, тому в цьому поколінні було кілька спеціалізованих прискорювачів. Принагідно компанія відмовляється від бренду Tesla. Найпотужнішим рішенням для обчислень стає Nvidia A100. Це справжній обчислювальний монстр, який став прямим наступником Tesla V100 для сфери ШІ-обчислень. В основі пристрою найпотужніший чип GA100 з 6912 ядрами CUDA та 432 тензорними блоками, плюс неймовірні на той момент 40 ГБ пам'яті HBM2. Через рік було представлено вдосконалену версію A100 з HBM2e 80 ГБ та інтерфейсом PCI Express. Прискорювачі A100 досі активно використовуються для навчання великих моделей ШІ.

Nvidia A100

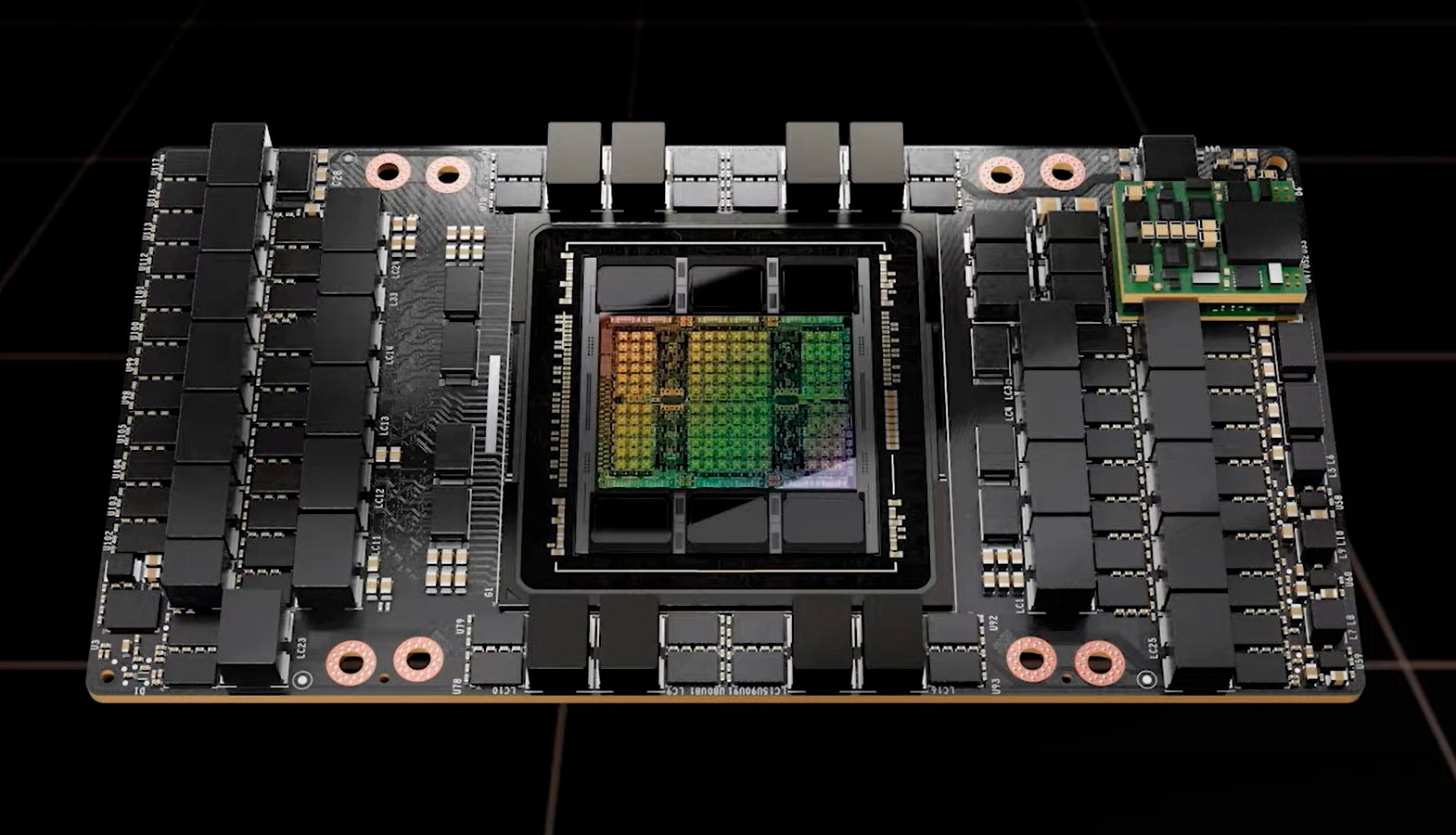

Наступним серйозним кроком компанії став запуск прискорювачів H100 на архітектурі Hopper. Тут Nvidia знову пішла шляхом поділу архітектур, і Hopper створювався окремо з прицілом на високопродуктивні обчислення ШІ в системах обробки даних. Це високопродуктивний чип з підтримкою швидкісних інтерфейсів NVLink для створення великих конфігурацій з можливістю масштабування. В основі H100 графічний процесор GH100 з 16896 обчислювальними ядрами CUDA та 528 оновленими тензорними ядрами. Прискорювачі першими використовували швидку пам'ять HBM3 об'ємом 80 ГБ.

Nvidia H100

Рекордна продуктивність, масштабованість та якісна підтримка платформи CUDA з постійними програмними оптимізаціями для обчислень ШІ забезпечили неймовірний успіх. Запуск H100 остаточно вивів Nvidia у лідери апаратних рішень для ШІ.

Збір системи Nvidia HGX H100 на базі 8 прискорювачів H100

Варто зазначити, що саме 2022 рік пов'язаний із запуском безлічі популярних сервісів на основі ШІ. Перші спроби у цій сфері були й раніше, але саме у 2022 році стартували ChatGPT, Stable Diffusion, Midjourney та інші проєкти. Вони продемонстрували споживачам неймовірні можливості нейромереж для генерації контенту та забезпечили вибухове зростання інтересу до таких сервісів. А вже в поточному році ми бачимо неймовірні проєкти рівня генератора відео Sora від OpenAI, і це далеко не межа.

На тлі такого технологічного зльоту відвантаження прискорювачів Nvidia відбувається у величезній кількості. Постачання упирається тільки у можливості TSMC з виробництва чипів Hopper. В результаті акції Nvidia стрімко зростають, і компанія швидко обганяє інших технологічних гігантів, позиції яких нещодавно здавалися непорушними. У 2023 році капіталізація компанії перевищила трильйон доларів США, а вже у 2024 році вона досягла рівня 2,2 трильйона доларів. На момент написання даного матеріалу Nvidia знаходиться на третьому місці у списку найдорожчих компаній світу, поступаючись лише Microsoft та Apple.

Звичайно, акцент зі споживчої графіки трохи змістився, але Nvidia не кидає цей напрямок і продовжує його активно розвивати. У 2022 році запущено серію відеокарт GeForce RTX 40 на архітектурі Ada Lovelace. Тут немає сенсу вдаватися в деталі, оскільки це було нещодавно, і відеокарти активно продаються на ринку. Крім апаратної еволюції також відбувається і поступова програмна еволюція.

Із запуском Ada Lovelace компанія представила нову технологію DLSS 3 з генерацією кадрів — тепер нейромережа не лише добудовує кадр, а й створює проміжні кадри. Це забезпечило додатковий стрибок у продуктивності при активації DLSS. Згодом DLSS оновили до версії 3.5 та додали технологію реконструкції променів. А у 2023 році ми побачили перші ігри, де не тільки активно використовується трасування променів, а й більш просунута техніка трасування шляху.

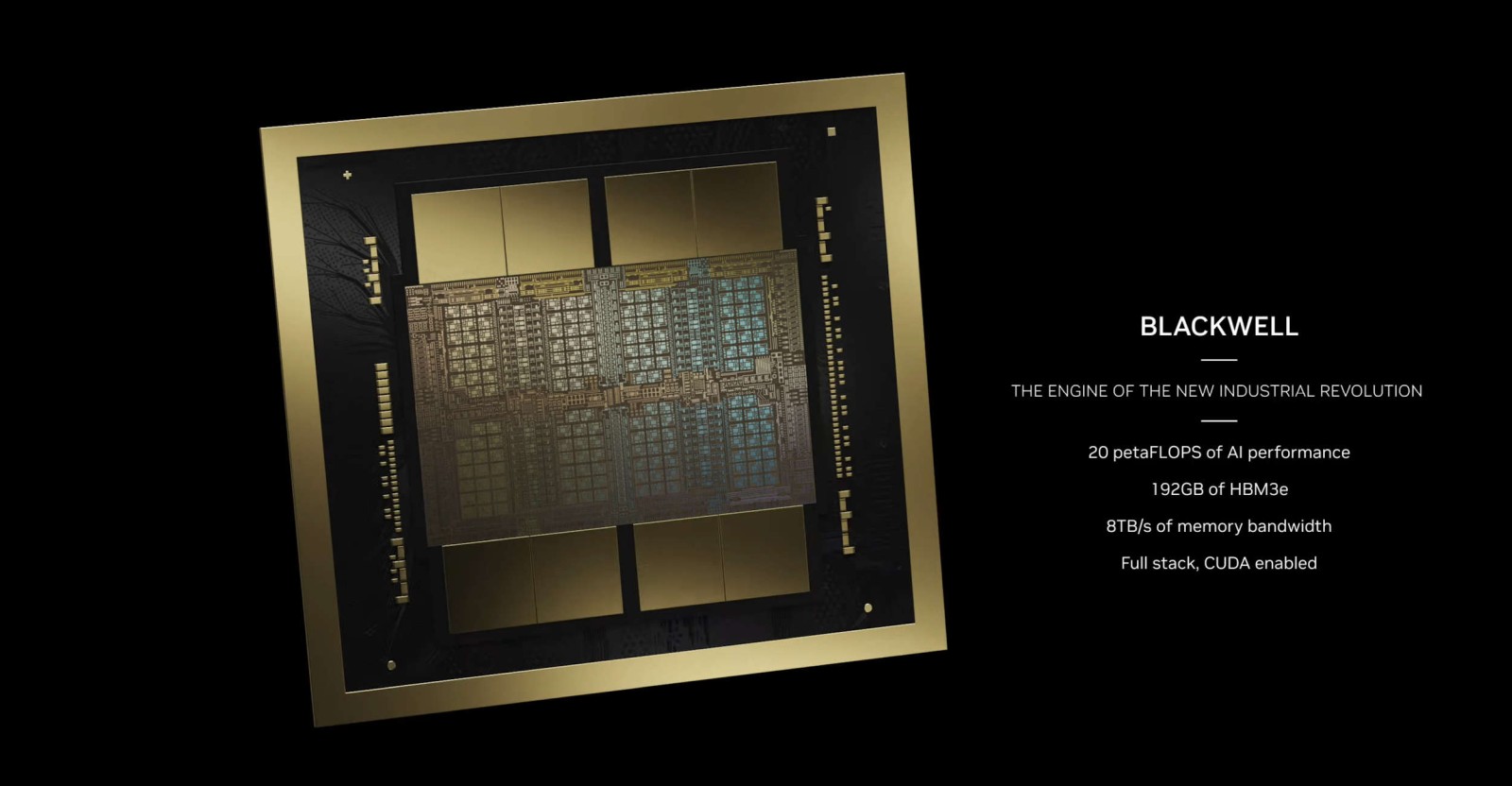

Одночасно компанія прокачувала Hopper. Було представлено суперчип GH200, який поєднує CPU з 72 ARM-ядрами та два GPU Hopper, з'явилися прискорювачі H200 з новою пам'яттю HBM3e об'ємом 141 ГБ. Ну а нещодавно компанія анонсувала нове покоління прискорювачів Blackwell.

Зараз ми знаходимося на цікавому етапі технологічного розвитку, коли впровадження технологій на базі ШІ стає масовим та повсюдним. І компанія Nvidia відіграє важливу роль у цьому процесі, забезпечуючи технічну базу для такої революції. Це, зокрема, вплине й на ігрову промисловість. Вже зараз ми бачимо спроби впровадження ШІ у процес створення NPC та розробки сценаріїв, плюс можливість використання генеративних ШІ для створення 3D-прототипів та текстур. Але цікавіше, яким шляхом піде ігровий рендеринг. Nvidia вже була на передньому краї прогресу, коли сприяла впровадженню трасування променів. Зараз у нас є технологія DLSS, яка добудовує кадри та додає проміжні кадри. Але чи можна піти далі та замінити основні етапи рендерингу генерацією? Сам Дженсен Хуанг під час останньої конференції GDC говорив, що це цілком можливо. Поки це лише припущення, але з його погляду, через 10 років ми можемо побачити новий етап розвитку подібних технологій. Можливо, у майбутньому нейромережі навчаться генерувати цілі віртуальні світи, а саме поняття відеокарти переродиться на щось нове. Це буде цікавий час та дивовижна епоха.