Итак, компания ATI обновила линейку видеокарт начального уровня пол года назад. За это время на рынок уже успели попасть урезанные варианты базовых моделей для заполнения ниши до 80 долларов. Сам же чип RV515 никто не урезал - 4 пиксельных и 2 вершинных конвейера остались на месте, частота чипа около 450 МГц, как и положено, а вот память… Обладая всего 64 битовой разрядностью шины, частота зависит от типа памяти и от производителя видеокарт. Если у стандартного варианта видеокарты частота памяти равна 500 МГц, то в этом случае она варьируется, к примеру, от 486 до 712 МГц. Ну, об этом ниже.

Начнем, пожалуй, в алфавитном порядке, и первой по списку будет видеокарта от компании ASUSTeK.

ASUS EAX1300/TD/128M/A

Видеокарта от ASUS как всегда в коробочном исполнении, но уже со спартанской комплектацией.

В комплекте присутствует краткая инструкция и два диска - один с мануалом, другой с драйвером и программным обеспечением:

Asus Video Security Online 3.5.1.1 - позволяет с помощью видеокамеры превратить компьютер в центр видеонаблюдения

Asus GameLiveShow 1.22 - транслирует игру в реальном времени в Интернет

Asus GameFace Messenger 2.1 - позволяет обмениваться сообщениями и устраивать игровые конференции

Asus SmartDoc 4.80 - утилита мониторинга

Переходников, шнуров в комплекте не было.

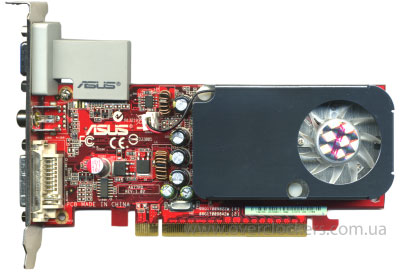

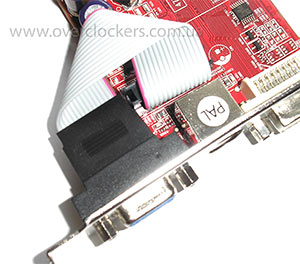

Карта, как обычно при 64 битах, имеет узкий дизайн. Ничего необычного, кроме шлейфа, идущего от видеокарты к разъему D-Sub - он выполнен в виде платы, припаянной к видеокарте и к аналоговому разъему. А чтобы конструкция не повредилась от механического воздействия, она защищена пластмассовым кожухом.

На карте также распаян разъем DVI, который уже стандартен даже для бюджетного класса, и TV-выход в виде тюльпана. Кстати это единственная карта в этом тесте с таким разъемом, обычно, в последнее время идет либо S-Video, либо HDTV.

Система охлаждения, состоящая из алюминиевого радиатора и такой же крышки, накрывает половину платы.

Вентилятор достаточно тихий и лишний шум на фоне других кулеров вас не потревожит. Для того чтобы исключить скол ядра, между платой и радиатором расположены три круглые резиновые подушечки, которые очень сильно были приклеены, и оторвать радиатор от видеокарты оказалось не так легко :) .

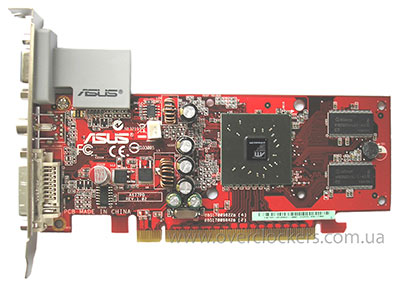

Ну и сама плата без системы охлаждения:

Чип:

Память, как видно на фотографиях, в упаковке TSOP в количестве четырех штук, производства Infineon, со временем доступа 4 нс, что соответствует рабочей частоте в 500 МГц, но мы еще посмотрим на какой частоте она работает.

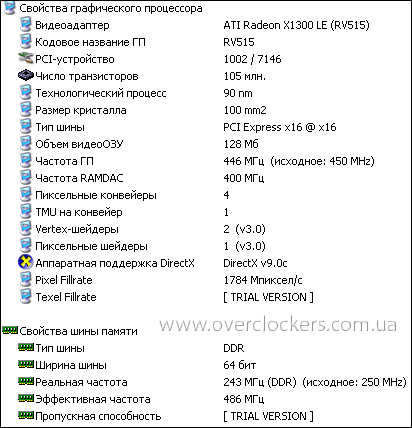

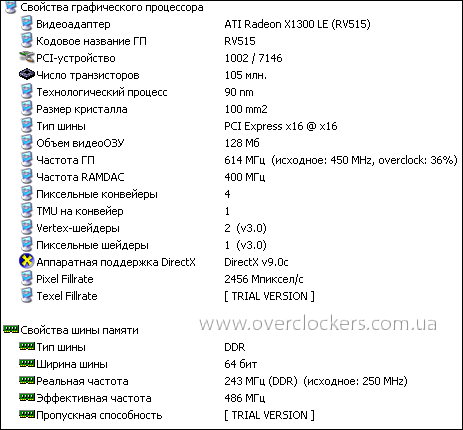

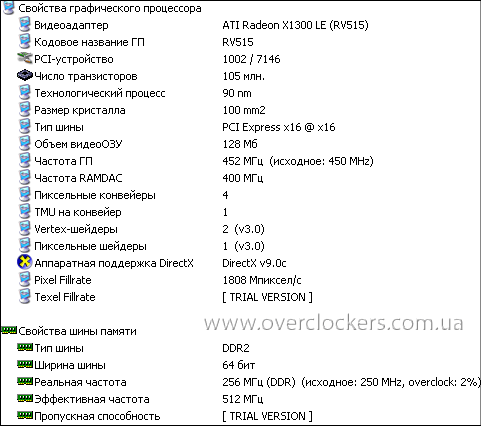

Ну и главное - разгон! Для диагностики применялась trial-версия утилиты Everest Ultimate Edition 2.80, для разгона - RivaTuner 2.15.8. К 16 релизу этой замечательной программы тесты уже были выполнены, так что новую версию попробовать не получилось. С номинальных частот, которые составили, а тут самое интересное, 445 МГц по ядру (не 450, как положено по спецификации), и 243(486) МГц по памяти - еще лучше,

карта разогналась до 614 МГц по чипу, и 243(486) МГц по памяти.

Да, память не разогналась, и не только на этом экземпляре X1300 (скорее всего, так называемый X1300 LE), на любом из этого обзора. Ни ATI Tray Tools, ни ATITool последних версий, также не помогли, система просто зависала после изменения частоты видеопамяти. То, что память не гонится на X1300 - не удивляет, но то, что инженеры ASUS занизили частоты, вот это удивило. Обычно такой болезнью страдают производители NONAME, но чтобы ASUS…С чем это связано, не понятно.

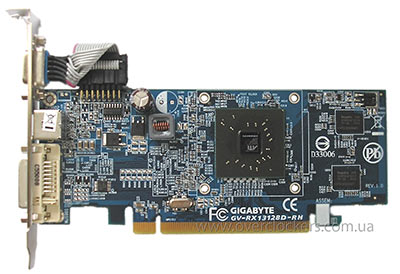

Gigabyte GV-RX13128D-RH

Видеокарта производства Gigabyte попала на тестирование в одном антистатическом пакете. Вообще, в этот раз пришлось тестировать видеокарты, половина которых была без каких либо дополнительных аксессуаров, отсутствуют даже диски с драйверами, остальная же половина - в коробочном исполнении.

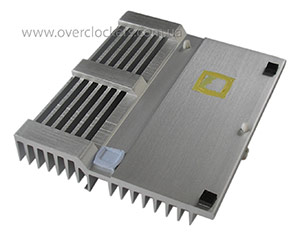

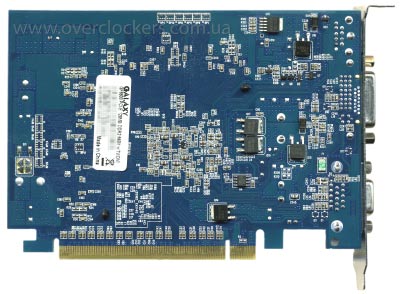

Вернемся к видеокарте. Из-за системы охлаждения карта кажется полноформатной, но на самом деле она такая же узкая, как и видеокарта от ASUS.

Сняв крышку системы охлаждения, можно в этом убедиться. Разъем D-Sub соединен с платой уже привычным способом - через шлейф. Видеовыход S-Video, цифровой разъем, все вполне стандартно. Бросается в глаза катушка, которая находится в корпусе и залита веществом, похожим на эпоксидку.

Система охлаждения пассивная. Часть радиатора, которая находится за платой, имеет сквозные отверстия, благодаря которым происходит дополнительное охлаждение за счет потоков воздуха проходящих внутри корпуса. В роли термоинтерфейса выступает "жвачка" желтого цвета, которую можно отмыть с помощью нашей технологии.

Радиатор, кроме ядра видеокарты, также охлаждает MOSFET через толстую термопрокладку. А чтобы чип не получил сколы по краям от неумелых пользователей, на радиаторе есть резиновые подушки. Во время работы в номинальном режиме радиатор нагревается достаточно сильно, после разгона, за радиатор невозможно даже взяться руками. Так что, если вдруг будете разгонять видеокарту, не забудьте ее дополнительно охлаждать вентилятором.

Видеокарта без системы охлаждения:

Память DDR2 производства Hynix, расположена с обеих сторон платы по две штуки, время доступа 2,8 нс, что соответствует рабочей частоте 714 МГц.

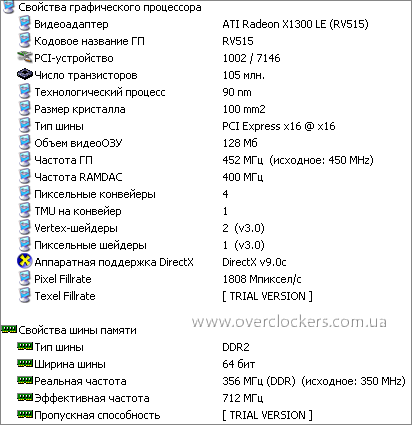

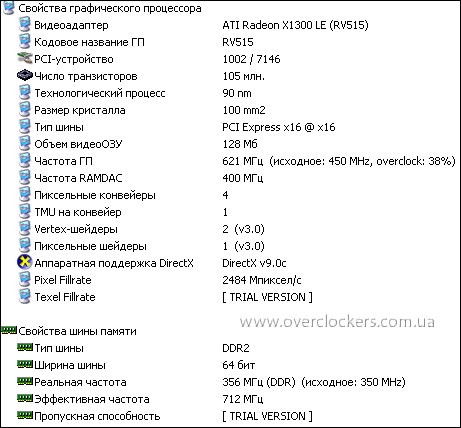

Разгон ядра оказался даже немного выше, чем в первом случае, разогнавшись с номинальных 452 МГц до 621 МГц.

Память естественно не разогналась, и работала на стандартной для такого типа частоте 356(712) МГц.

Разгон с пассивным охлаждением, оказался даже лучше, чем с активным на видеокарте от ASUS. Что ж, очень даже не плохо, если можно так выразиться о карте low-end. И это не смотря на "раскалившийся" радиатор. В этот раз видеокарта производства Gigabyte порадовала своими возможностями, но попадаются экземпляры и со скудными способностями. И такое бывает, чуть ли не раз через раз.

HIS Radeon X1300 HyperMemory II

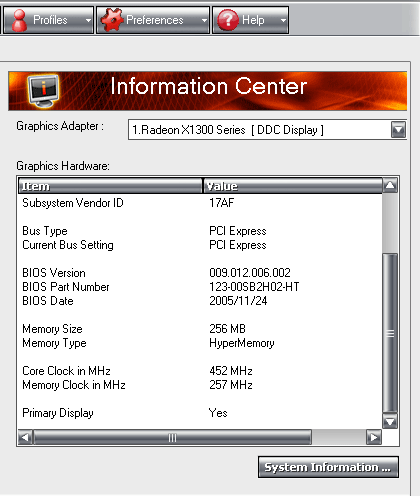

Единственная видеокарта, поддерживающая технологию HyperMemory (аналог TurboCash от nVidia, т.е. использование локальной памяти для нужд видеоадаптера) - карта производства компании HIS. Имея 128 МБ памяти на борту, драйвер видеокарты расширяет ее до 256 МБ, что можно просмотреть с помощью ControlCenter входящий в Catalyst:

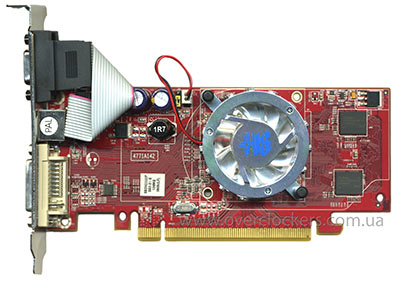

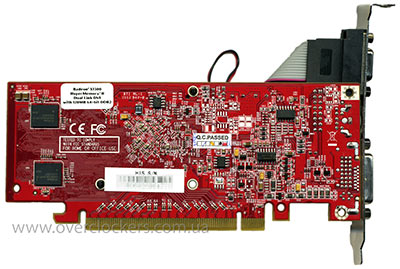

Видеокарта HIS, как и карта от Gigabyte, попала на тест в одном антистатическом пакетике. Узкоформатный дизайн, красный текстолит, разъемы: DVI, S-Video, аналоговый D-Sub соединенный через шлейф - вот, пожалуй, вкратце данные этой видеокарты.

Все кажется нормально, кроме немного искривленной задней планки. Причина этому - разъем D-Sub упирается в разъем на видеокарте.

Как при проектировании могли такое допустить? Или же это просто использование деталей не соответствующих нужным характеристикам? Ну что ж, брак делают не только у нас, но и на востоке. :)

Система охлаждения - активная и достаточно тихая. Радиатор выполнен из алюминиевой пластины с согнутыми ребрами-лепестками. Вентилятор прозрачный, но, увы, не светится - экономить то надо. Сверху накрывается алюминиевой крышкой-решеткой.

На этой видеокарта память также стандарта DDR2, но уже со временем доступа 2,5 нс производства Infineon.

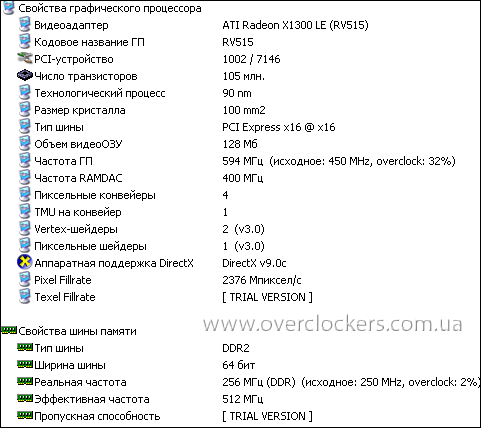

А вот с разгоном этой видеокарте не повезло. Да какой там разгон, карта даже в номинале показала наихудший результат. Возможно, технология HyperMemory работала не совсем корректно и даже мешала, потому, как другого объяснения столь низкому результату в тестах дать не возможно. Стандартные частоты чипа и памяти составили 452/256(512) МГц соответственно.

Разогнался чип всего до 594 МГц - это самый маленький результат из всех X1300 LE, которые попали в данный обзор.

Вот и познакомились с серией X1300, или все же с X1300 LE, хотя это лишь названия конечного продукта, ядро то осталось тем же - RV515. Перейдем теперь к конкуренту - GeForce 6600 128МБ 64 бит.

Galaxy GF6600PCI-E 128MB DDR2 64-b

Калифорнийская компания недавно ускорила свою средне-бюджетную серию видеокарт на основе GeForce 6600, увеличив частоту чипа в полтора раза и установив память типа DDR2. Вот и к нам попала одна из таких карт производства компании Galaxy.

Видеоадаптер относится к той половине, которая идет в коробочном исполнении.

В комплекте были диск с драйвером и ключиком nvtweak, позволяющий открыть раздел в драйвере для разгона. Также в коробке находились две инструкции и шнур S-Video.

Немного укороченный дизайн платы, остальных функциональных отличий не замечено. Естественно восемь посадочных мест под память DDR2 на лицевой стороне платы, четыре из которых заполнены соответствующими микросхемами.

Все разъемы на месте: цифровой DVI, аналоговый D-Sub и TV-выход.

Система охлаждения состоит из медной круглой пластины с припаянной медной гармошкой

Вентилятор немного шумноват по сравнению с вентиляторами других участников данного обзора, но имеет, синюю подсветку, что понравится очень экономным моддерам.

Немного обновленный чип:

Память производства Hynix, со временем доступа 2,8 нс, как и на видеокарте X1300 производства Gigabyte.

Изучив внешние характеристики видеокарты, перейдем к ядру и разгону. Все восемь пиксельных конвейеров на месте, как и три вершинных. Частота же чипа, как в 2D, так и в 3D, всегда одинаковая, и составляет 450 МГц. Память работает на частоте 274(548) МГц.

Разогнать карту удалось до 559 МГц по чипу, и до 313(626) МГц по памяти.

Для видеокарты на базе GF 6600 достаточно неплохой результат. Еще бы и ширину шины в 128 бит. А вот для самой памяти со временем доступа 2,8 нс, результат в 628 МГц удручающий.

Осталось теперь сравнить все видеокарты вместе.

Результаты

Тестовая конфигурация:

Материнская плата: Epox NPA+UL (nForce4Ultra)

Процессор: AMD Athlon64 3000+@2700 (9x300)

Оперативная память: Hynix D43, 2x512Mb PC3200@245 2,5-3-3-8-2T, dual channel

HDD: Samsung SP2004C, Samsung SP1213N

Блок питания: Chieftec HPC-360-202-DF

WindowsXP Pro SP2 RUS

RivaTuner 2.15.8

Everest Ultimate Edition 2.80

ForceWare 84.21

ATI Catalist 6.4

nForce chipset driver 6.70

Тестовая конфигурация была собрана в открытом корпусе, стоящем на столе. Вся система настраивалась на максимальное быстродействие, брандмауэр и система восстановления отключались, файл подкачки задавался размером в 1024 Мб. Так же драйвера настраивались на максимальное качество, остальные настройки - по умолчанию.

Для тестов применялись следующие приложения:

3DMark2005

Doom 3

Half Life 2

F.E.A.R.

Тесты проходили при разрешении экрана 1024x768 без антиалиасинга и анизотропной фильтрации. В синтетике использовались только игровые тесты. В игре Doom 3 качество графики выставлялось в режим "Высоко", в Half Life 2 - максимальные настройки, в игре F.E.A.R. качество графики выставлялось как "Высоко", мягкие тени - отключены.

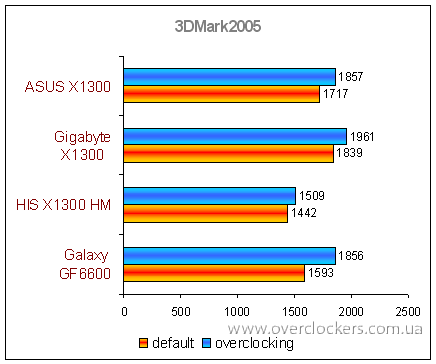

Как всегда, начнем с синтетического теста - 3DMark2005.

Вот он, низкий результат видеокарты от HIS, неужели действительно, технология HyperMemory так сильно влияет на производительность? Ведь карта даже при равных частотах со своими "братьями", находится в самом конце таблицы производительности. Видеокарта на основе GeForce 6600 показывает не менее странный результат - обладая восемью пиксельными конвейерами, по производительности она даже хуже, чем четырехконвейерная X1300. И только разгон позволяет догнать противника.

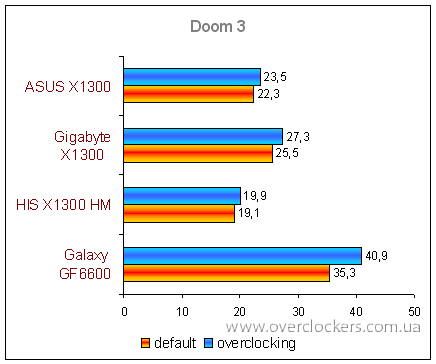

Следом идет Doom 3.

Какие частоты, какие конвейеры - приложение Doom 3 изначально заточено под продукцию nVidia, и этим все сказано. Так что, можно попытаться поиграть даже на такой видеокарте.

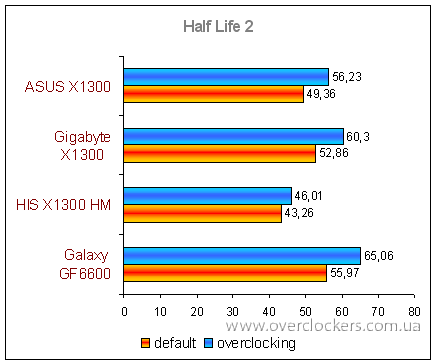

Как на счет Half Life 2?

Приложение любит мощные GPU, чему и доказательство - результат GeForce 6600 немного выше, чем у X1300. А играть можно на любой из этих видеокарт.

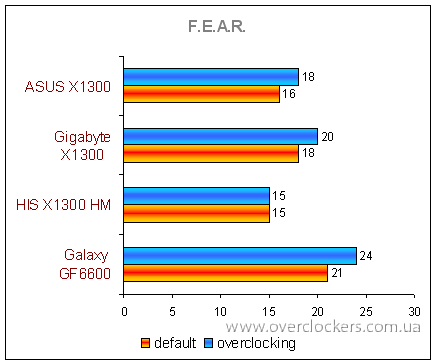

И в заключении F.E.A.R.

При таких настройках, играть не рекомендуется, если конечно, у вас имеются крепкие нервы, то вперед. А видеокарту HIS Radeon X1300 HyperMemory II, даже не рекомендуется разгонять - игра этого не заметила. Ну и GF6600 на первом месте с отрывом в четыре "очка" от самого быстрого X1300 в лице Gigabyte GV-RX13128D-RH.

Что же можно рассказать о разгоне 64 битового low-end? Да, его можно разгонять, только эффект от этого не такой, как если бы разгонялась видеокарта стоимостью хотя бы 100 американских долларов. Весь разгон тормозит пропускная способность памяти - сколь б вы не гнали видеокарту, результат будет расти не так быстро, как в 128 битных аналогах. Так что, при покупке видеокарты с прицелом на разгон или просто для игр, берите карту с шиной памяти 128 бит, никогда не прельщайтесь на урезанные варианты, даже если их стоимость ниже на 5-10 долларов.

А если вы все же берете видеокарту с урезанной шиной памяти, и вы часто "играете" в 3DMark, то хорошим выбором будет видеокарта Gigabyte GV-RX13128D-RH. Она достаточна "быстра", с пассивным охлаждением, и разгоняется не плохо. Если же вы играете в реальные игры - Galaxy GF6600PCI-E 128MB DDR2 64-b как раз для вас. Карту HIS Radeon X1300 HyperMemory II брать не рекомендуется, ни за какие коврижки. :)