Несмотря на то, что сегодня не только лишь все (с) могут позволить себе SSD, тем не менее, мало кто вне среды специалистов трезво понимает процесс выбора иначе, нежели «сортировать по возрастанию цены» в интернет-магазине. И что самое интересное — они, в общем-то, почти правы. Прошу отложить метание овощей за этот тезис и дочитать до конца.

Немного олдфажества

Типичный возрастной пользователь ПК на сегодня мог успеть пройти путь от кассет, с которых загружался Сommodore 64, ATARI или Sinclair, через НГМД прямиком к НЖМД и немного к оптическим дискам, а после — к современным по сути твердотельным накопителям.

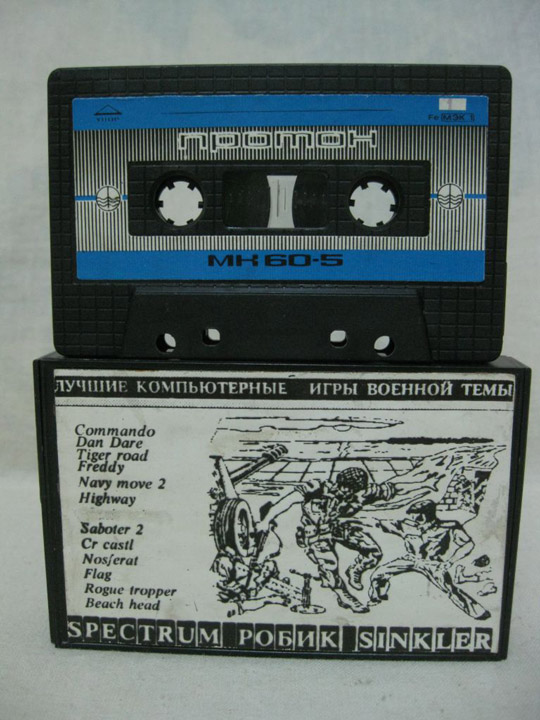

Эксклюзивы типа магнитооптики, стримеров, zip и перфокарт мы сознательно выносим за скобки, хотя по надежности со стримером сравнятся разве что наскальные формы передачи информации, но и скорости там не фонтан вкупе с последовательностью доступа. Магнитофон «Весна» с МК-60, где записан незабвенный Exolon и SoF, а так же, внезапно, Трансформеры (да-да, в них играли еще до того, как они стали мейнстримом), технически был тоже стримером, но по очевидным причинам в надежность не сильно умел. Загрузить ОС и прообразы тоже можно было не со всех этих носителей.

На фото тематический пример лота бесчисленных интернет-барахолок и аукционов, он приведен с двойной целью — если вчитаться во вкладыш, то можно узнать, что перед нами пример защиты информации избыточностью — по сути-то ленточный аналог зеркального рейда из двух носителей!

Источник — Skylots.org

Почему прямоугольник — диск?

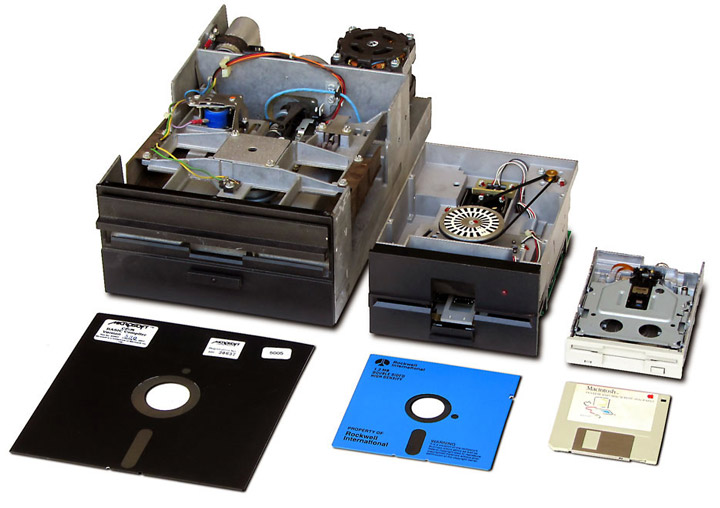

HDD, тем не менее, продолжает быть востребованным и сегодня, хотя и значительно потеснен твердотельными накопителями, по инерции именуемыми дисками. При этом мало кто из изучивших геометрию в школе, задается вопросом — почему прямоугольник уверенно называется диском? Здесь как раз все просто — жесткий диск, который снаружи прямоугольный и круглый внутри, — устоявшаяся фигура речи из английского языка — ведь ему предшествовали гибкие магнитные диски, которые до 3,5 дюймовых дискет (а именно дискетами у нас именовались гибкие диски) были реально гибкими. В общем круглая внутри дискета (а были они даже 8 дюймовыми) со временем получила корпус потверже.

А объемные носители НЖМД сразу поселяли в твердый защитный корпус с жесткими в прямом смысле и зеркальными на вид магнитными пластинами внутри, коих могло быть несколько — там уже была точная механика, защита от пыли, головки, электродвигатели и прочая электроника. В общем, круглую душу дисковых накопителей, которая была технически изначально обусловлена осевой моделью работы, в реальности давно не видел никто, но, как отмечалось, по инерции это все называлось дисками.

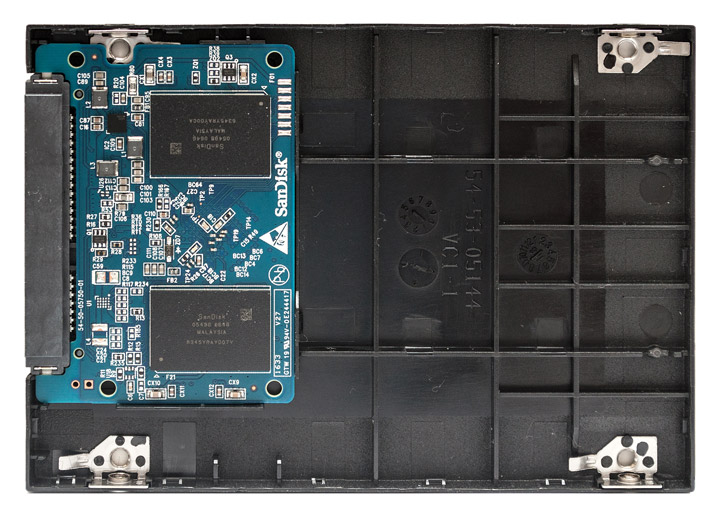

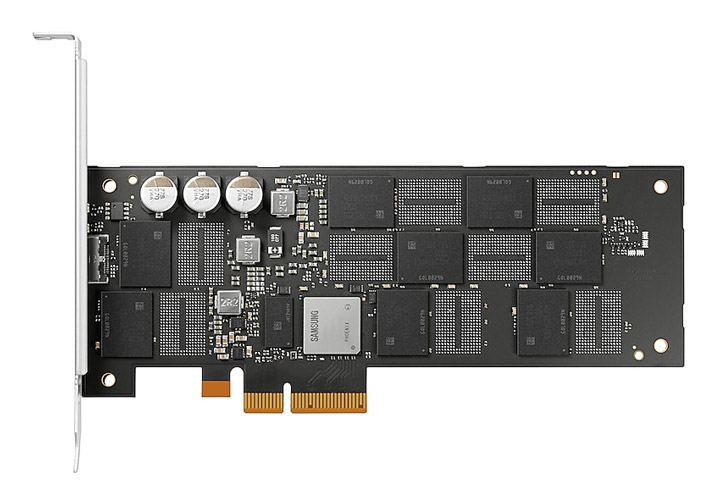

В т.ч. и твердотельные накопители, которые к круглому вообще никак не относятся и внутри могут выглядеть примерно как на снимке ниже. Размер платы меняется от модели к модели, но выглядят примерно так и это уже современный мейнстрим. Черное — 2,5″ корпус.

Н.Ж.М.Д.

Жесткие диски, они же винчестеры, достаточно долго были основными носителями в массовом сегменте. Скорости у них были низкие по сегодняшним меркам, но это были достаточно надежные изделия, которые производились почти двумя сотнями компаний, из которых сегодня осталось аж три — Seagate, WD и Toshiba.

Схема апгрейда накопительной подсистемы была годами понятна — старый носитель менялся на новый побольше с подходящим интерфейсом или добавлялся еще один. Конечно, с ростом объемов, плотности записи, скоростей шпинделя и количества блинов в сборке скорости, особенно линейные, у таких дисков подрастали, но не сказать, что взрывными темпами. В итоге дело физически уперлось в размеры и реально в воздух, и в герметичные камеры с крутящимися носителями стали закачивать менее плотный гелий т.е. рост шел обобщенно экстенсивно, а до внедрения революционных технологий записи мы не дошли и сейчас. При этом непонятно как там будет с надежностью, но, возможно, большинству это будет уже и не нужно, а вопросы эти будут беспокоить скорее дата-центры.

Новая надежда

Все дело в том, что лет 20 примерно назад научно-технический прогресс позволил начать продвижение твердотельных накопителей в массы. Сначала все было малообъемно, непонятно и дорого. Но со временем отрицание и гнев, с учетом цен, сменились на торг и принятие — ведь твердотельные носители предлагали недостижимые для механики скорости работы даже на ранних стадиях проникновения!

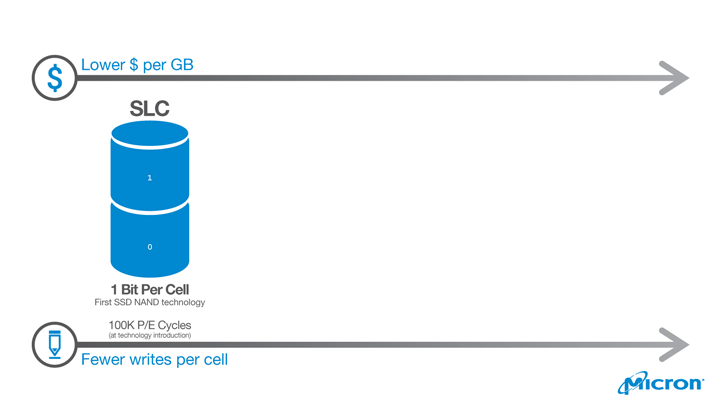

SLC — начало массовых SSD около 2007 года

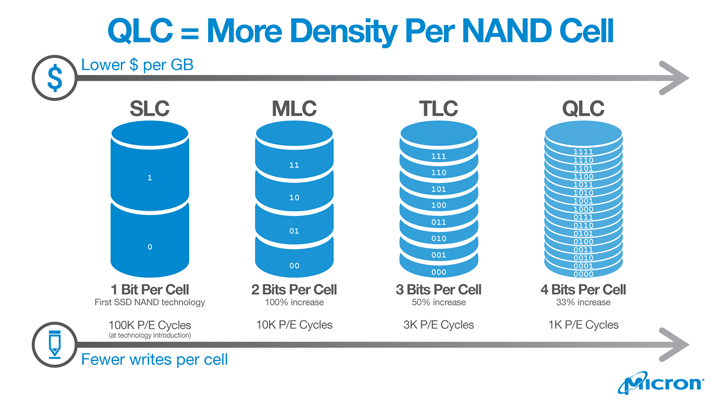

Первыми на рынок попали транзисторные накопители, в которых одна ячейка умела хранить один бит информации путем определения всего двух уровней заряда — заряжено-разряжено, грубо говоря. За технологией закрепилось рыночное название SLC (Single level cell) — одноуровневая ячейка (здесь и далее мы используем элементы инфографики Micron).

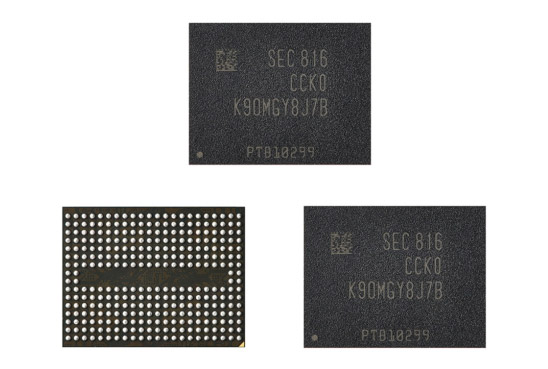

Ячейки эти собирались в массив, который внешне представлял собой то, что обычные граждане называют чипом. На иллюстрации ниже черная внешняя оболочка чипа представляет собой пластиковый корпус для физической защиты массива от внешних факторов. На него обычно наносится маркировка для идентификации. В данном конкретном примере SEC означает, что изделие вышло из стен фабрики Samsung. На обратной стороне расположена контактная группа.

Сам же твердотельный «диск» внутри знакомого корпуса, а первые серии выполнялись в форм-факторе 2,5 и 3,5 дюймовых HDD, представляет собой печатную плату с массивами ячеек в виде поверхностно монтируемых чипов, специальный контроллер управления этим массивом и прочие компоненты. В зависимости от конкретного решения может быть или не быть в наличии буфер из DRAM. Это если очень в общих чертах.

Ввиду отсутствия механики для твердотельных накопителей понятие «время доступа» поменяло физическое выражение. В НЖМД речь шла о времени позиционирования головок, физическом месте расположения данных на носителе, скорости вращения и т.п. Всего этого у твердотельного накопителя не было и время доступа скорее подразумевало время обработки контроллером запроса и сбора данных по массиву, которые могли физически находиться где угодно, но это не имело никакого значения для пользователя. Контроллер сам решал, что куда физически располагать и как потом это логически возвращать в виде данных, как исправлять ошибки, что делать с выработавшими ресурс ячейками, как взаимодействовать интерфейсам и прочее. По сути, реализация возможности массива ячеек зависела от контроллера, который ими управляет, уровня его исполнения, быстродействия и качества микропрограммы.

Фактически твердотельный накопитель был лишен главной особенности старого HDD — точной механики, которая имела свойство изнашиваться. И хоть не каждый пользователь ухитрялся увидеть выработку механического ресурса НЖМД, тем не менее, подшипники мотора, вращающего шпиндель, не вечные, точность позиционирования головок прецизионно обеспечивать вечно тоже невозможно, и самое главное — под воздействием внешних факторов носителю и данным мог быть нанесен серьезный урон. Удар, вибрация и прочее неизменно сокращали срок жизни механического носителя. Температура, судя по статистике, играет свою отдельную скрипку в оркестре факторов выхода HDD из строя. Правда вопрос количества перезаписей секторов на пластинах жесткого диска, в отличие от твердотельного, ввиду магнитной технологии первого, не стоял вообще никогда - механика износится заведомо раньше исчерпания магнитного ресурса носителей, который вообще не считается и не нормируется для масс. Средний срок жизни жесткого диска можно оценить в 30000–50000 часов работы. Скачки в сети и факты включения-выключения тоже негативно влияют на этот показатель. Однако справедливости ради нужно заметить, что раскопки сайта Seagate.com могут привести нас по адресу. Там мы, внезапно, узнаем, что Seagate ведет в своих жестких дисках статистику показателя Workload Rate Limit (WRL). Это что-то вроде расчета годового пробега в терабайтах. Seagate условно отводит механическому диску некорпоративного класса 180 терабайт в год или примерно 340 мегабайт на минуту работы шпинделя в режиме чтения или записи (нагрузка в этих режимах суммируется для расчета). Компания при этом замечает, что на гарантийные обязательства этот показатель в общем случае не влияет, а рассчитывается для того, чтобы зафиксировать порог нагрузки, при котором вероятность поломок накопителя возрастает. Бытовому пользователю столкнуться с такими нагрузками придется вряд ли. Диску корпоративного сегмента по логике Seagate при этом полагается 550 терабайт на год нахождения включенным.

Для рабочей станции или стойки в дата-центре вибрации конечно вторичны, а температура регулируема, но вот в портативной технике это все могло одномоментно привести к серьезному ущербу. Производители пытались бороться с этим разными способами. HP, например, в отельных сериях корпоративных ноутбуков, устанавливала ПО, которое, зафиксировав свободное падение, парковало головки носителя, что, впрочем, помогало не всегда. По этой же причине механические носители не прижились в автомобильной электронике — вибрации, знакопеременные температурные нагрузки и т.п. не позволяли использовать массово такие решения. Японцы конечно бы что-то придумали, но нишевые продукты либо стоят дорого, либо плохо окупаются. Поэтому в нашей памяти останутся предложения типа AVIC-ZH900MD от Pioneer за почти 3500 долларов как солидная альтернатива небольшой квартире в областном центре тех же лет. А ведь Pioneer предлагал HDD аж на целых 30 ГБ в 2004-то году в машине!

В общем, механика вроде как стала считаться решением устаревшим. Все вроде бы и так, если бы не одна особенность. Вышедший из строя НЖМД, если он физически не пострадал внутри и на поверхности рабочих блинов, можно временно вернуть к жизни в большинстве случаев за относительно адекватные деньги. Если повезет крупно, то достаточно будет заменить физически вышедшие из строя детали на такие же изделия этой же аппаратной ревизии и этого может быть достаточно, чтобы прочитать записанное. Работать такой восстановленный диск долго не будет по причине попадания пыли — она раньше или позже выведет диск из строя окончательно, но для чтения его целиком этого времени заведомо достаточно. Поэтому в 90-х вполне можно было увидеть картину ремонта HDD с сигаретой в зубах. Расчета на длительную работу после снятия крышки уже тогда никакого не было.

Если повезло меньше, то после ремонта механики специалист по восстановлению может поработать с содержимым на логическом уровне. Это дороже, но технологий поднятия даже пострадавших данных немало. Если рабочие пластины физически не повреждены головками, то в случае механического носителя шансы на восстановление данных при иных видах поломок очень высоки. Поэтому при списании корпоративных накопителей их сначала тщательно стирают, а потом уничтожают физически — конкуренты могли осуществлять промышленный шпионаж, даже подбирая, казалось бы, мусор.

Отказ от механики видится благом. Никакой тебе вибрации, свиста мотора и звуков позиционирования головок! Тишина и порядок.

Правда в случае физической поломки твердотельного носителя вероятность восстановления данных стремится к нулю т.к. мы помним, что, даже пересадив чипы памяти на донорскую плату никто, кроме старого контроллера, грубо говоря, не знает, как с ними работать, и что и как там было записано. В отдельных случаях узкий специалист по восстановлению может удалить защитный пластиковый слой чипа памяти и попробовать подключиться напрямую к массиву внутри. При определенных обстоятельствах это может дать результат, если сильно повезет и искомые данные целиком будут размещены физически в одном массиве, а на плате твердотельного накопителя их может быть много. Но даже в этом случае процесс поднятия данных нужно будет продолжать на логическом уровне, что по силам очень немногим и стоит поэтому совсем недешево. С одночиповыми «флешками» такое проходит, но конкретный вышедший из строя SSD — не «флешка», да и логика работы, задаваемая контроллером, может не предусматривать самой возможности такой процедуры. А как показывает практика, выходят твердотельные накопители из строя почти внезапно. Далее они даже BIOS или UEFI не видятся. Конечно, выходу из строя предшествует начало использования резервных блоков, но кто смотрит SMART каждый день? И почему производитель не снабжает товар собственной маленькой программкой, которая бы в системном трее сообщила, при случае, об ухудшении ситуации с ресурсом? Ведь признаки таких проблем установлены опытным путем, а производителю такой бонус не будет стоить почти ничего.

В общем, твердотельные носители имеют особенности, которые надо учитывать. И это существенные особенности. О них — ниже.

Но вернемся к SLC. Эти массивы ввиду технологии как таковой и благодаря толстым техпроцессам производства оказались очень живучими. Обобщенно считается, что ячейка SLC-типа способна пережить до 100 тыс. перезаписей.

Вопрос к кукушке

Если подойти к вопросу широко, то срок жизни твердотельного накопителя можно прикинуть как его объем, умноженный на ожидаемое эффективное число перезаписей. Именно прикинуть т.к. в процессе работы происходит технологическое использование некоторых ячеек, стирание, запись разных объемов данных и блок стирания обычно больше блока записи. В итоге при запросе ОС на запись одного объема данных физически в память носителя может произойти запись на бОльшую общую сумму т.к. если мы, например, немного меняем текст этой статьи и сохраняем его, то на уровне твердотельного носителя, особенно ранних серий, данные прочтутся, изменятся, сотрутся старые, запишутся новые и это произойдет через транзитные ячейки, которые потом тоже надо не забыть стереть. И все это целыми блоками, и стереть придется больше, чем записать — в страницу памяти SSD помещается 4 NTFS-кластера, а в случае, когда данные на запись приходят объемами менее кластера, но не одновременно, а с небольшими промежутками, то на физическом уровне перезаписываться будут кластера полностью. Контроллер, конечно, разберется что и как, но физически диск получит данных на запись больше, чем мы фактически изменяли в тексте, найдя опечатку. Это называется усилением износа — в результате логики работы твердотельного накопителя физических перезарядов ячеек в массиве памяти происходит несколько больше, чем фактически запрашивается системой, которая не в курсе внутренней кухни накопителя.

Бороться с этим явлением можно на логическом уровне, научив, например, контроллер, вычленять изменяемый блок и записывать его в новом виде в новое место, а старый помечать, как возможный к использованию после обработки, т.е. после физического стирания, на которое надо потратить ресурсы т.е. время. При этом логическому адресу указанных данных присвоится новый физический адрес внутри носителя. Затем неактуальные блоки будут стерты физически. В итоге это приведет к тому, что скорость записи на такой носитель упадет ввиду необходимости выполнять целый ряд логических процедур перед завершением запроса на запись.

Чем сильнее заполнен диск, тем сильнее будет напрягаться контроллер для поиска вариантов размещения, чтения, стирания, записи, перемещения и т.п. Внешне это будет выражаться как падение скорости. Но все эти особенности не видны ОС на логическом уровне т.к. общение с железом носителя происходит через контроллер и только ему известно, что и как там в реальности.

Т.е. паспортную скорость поработавший диск по указанным причинам ожидаемо не покажет, и это надо было как-то решать.

Решили выделением незадействованных областей и процессом т.н. сбора мусора, когда контроллер в свободное от работы время физически удаляет устаревшие блоки и приводит номинально свободное место в свободное реально т.е. в такое, которое не требует потерь времени на предварительное стирание и прочие действия во время рабочей нагрузки.

Если сбор мусора прошел вне пика нагрузки, то, когда такой пик повторится, скорость записи будет близка к таковой на физически чистый и свободный накопитель.

Сбор мусора проводится командой известной как TRIM, которую подает ОС, но даже ее первые твердотельные накопители правильно исполняли не все, ввиду чего со временем скорость их работы неизбежно падала, и восстановить ее можно было только полным физическим стиранием.

Все вышеописанное происходит естественно за счет операций с ячейками, которые не вечны. Да, в процессе работы ячейки твердотельных накопителей физически изнашиваются. И хотя логика работы с ними не подразумевает определение состояния каждой отдельной ячейки, тем не менее, средние показатели их жизнеспособности определяются по некоторой логике и когда чтение становится невозможным, некий массив выводится из оборота контроллером. Запомним этот момент.

Таким образом, потребительские SSD ранних поколений были ощутимо быстрее любых HDD, особенно при работе с мелкими данными т.к. винчестер в случае фрагментированного физически файла должен был для его чтения «постучать» головками в разные места диска, а SSD головок не имел и скорость отклика определялась во многом возможностями контроллера по сбору данных в электронном виде на уровне внутренней логики носителя. SSD так же был лишен проблем с механикой ввиду ее отсутствия, но его высокие скорости деградировали со временем по причине несовершенства раннего управляющего ПО, т.е. прошивок, впрочем, далеко не до уровня НЖМД. Стоил твердотельный накопитель дорого, но при этом имел такой ресурс ввиду особенностей организации и производственных возможностей, исчерпание которого дождаться было тяжело.

Машины на основе системных твердотельных накопителей загружались быстро и обеспечивали высокую отзывчивость пользовательских интерфейсов, а так же несравнимую с HDD работу с массивами мелких файлов, что было крайне важно для дата-центров, ориентированных на чтение, но до массового заезда туда SSD было еще далеко.

Итак, SLC считается очень выносливой твердотельной памятью, но… она практически недоступна сегодня для массового пользователя т.к. стоит дорого, а чудом дожившие до наших дней экземпляры первых серий не блещут объемом и скоростью. Так, например, на барахолке можно найти 2 ГБ SLC-носители, которые, вероятно, стояли в чем-то типа банкомата, проскакивают даже Mtron, но все это сегодня интересно в основном как музейные экспонаты.

MLC — 2011

Прогресс не стоял на месте, и разработчики предложили в одной ячейке твердотельного накопителя определять не два состояния заряда, а больше. Технологические возможности позволяли уверенно работать с четырьмя уровнями заряда, и в массовый сегмент вышел новый тип памяти.

Маркетологи должны были показать, что новый тип гораздо гораздее прошлого. Девальвированное массовым необоснованным применением «2х!» привело к тому, что надо было выдумывать что-то посолиднее и слово MULTI оказалось кстати. Так на рынке появилась знаменитая MLC-память: Multi level cell с 2 битами на ячейку, 4 определяемыми состояниями заряда в ней. Логичнее было бы Dual level cell или Two level cell, Bi level cell и т.п. Но зачем маркетологам в логику, когда и потребителю заходит?

Но увеличение распознаваемых уровней заряда в одной ячейке вместе с утончением технологического процесса производства неизбежно привело к тому, что на физическом уровне обеспечить такую же выносливость ячеек новой памяти оказалось невозможно. Уверенное чтение после некоторого количества рабочих циклов не происходило даже с улучшенными алгоритмами коррекции ошибок в новых контроллерах — электроны разбегались как тараканы. Считается, что твердотельные ячейки в MLC-массивах способны пережить от 3000 до 10000 перезаписей. Т.е. падение ресурса на порядок по сравнению с SLC!

Примерно здесь и начинаются легенды и басни о реальном ресурсе твердотельных накопителей. Напомню, что обобщенно еще недавно твердотельные накопители в общественном сознании неспециалиста считались по этой части проблемными. Говоря проще — долго не жили, ведь только заявленный ресурс упал на порядок, а гарантированные производителями ресурсы оказывались в документации еще ниже. Заимела место невиданная в случае HDD тенденция экономии ресурса твердотельных накопителей особо экономными частными пользователями. Ведь при типично небольших объемах товарных SSD казалось, что перезаписать их несколько тысяч раз можно будет достаточно быстро! Пользователи задались вопросом сбора статистики среднесуточных записей в разных сценариях работы. Появились даже сайты, которые делили заявленный производителем ресурс конкретной модели твердотельного накопителя на среднюю суточную запись и прикидывали количество лет эффективной работы конкретного устройства. Казалось, что индустрия допустила солидный просчет так сильно снизив ресурс, но самое интересное было еще впереди.

До дыр!

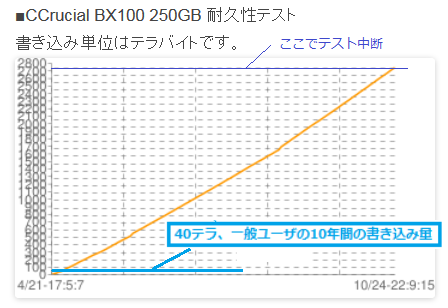

В сети можно найти много энтузиастов, которые занимались исследованиями ресурса различных твердотельных накопителей частным образом. Самих производителей памяти не так уж и много и продукт у них бывает разной степени кондиционности. Лучшее, как правило, оставляют для собственного бренда, отличное и хорошее могут продать стороннему производителю, который может и перемаркировать чипы, что-то попроще уедет в азиатские локальные бренды, а совсем уж треш пойдет в великий «ноунейм». Контроллеры тоже бывают разных производителей и разных поколений. Где-то используются DRAM-буферизация и т.п. В общем, комбинаций может быть много, и неплохо было бы увидеть результаты компаративной аналитики. И они не заставили себя долго ждать — мастера протирать SSD до дыр установили, что ресурс MLC памяти в отдельных случаях сильно превышал заявленный. Так, например, мой Crucial BX100 на 256 ГБ, используемый в «печатной машинке», где набирается этот текст, по заявлению производителя имеет ресурс в 72 ТБ. Это всего-то 300 перезаписей полного объема. По сравнению с 100 000 ресурса SLC, казалось бы, полное фиаско компании Micron! Но на практике исследователь из Японии записал на такой диск почти 3 ПБ и на этом процесс не завершился, а это уже более 10 000 перезаписей, что в 300 с лишним раз больше гарантии.

Где же закрались нестыковки? Они в методике. Многие подобные тесты построены на цикличной модели перезаписи носителя до фактической им утраты работоспособности, т.е. когда контроллер не способен больше нормально работать с массивом в результате разброда и шатания электронов в ячейках. Но это никак не является показателем т.к. в ходе теста носитель все время находится под током. А что будет, если, скажем, на петабайте завершить тест и обесточить накопитель? Насколько долго технология позволит удерживать заряд по ячейкам, т.е. сохранять информацию читаемой? Неделю, месяц, год? Есть стандарты и производитель, очевидно, посчитал, что выполнит их с запасом при оглашенном ресурсе. На практике может быть и больше. Главное, чтобы не меньше, а то исками закидают. Возможно коллективными. Конфликты с Аpple научили, что к единичному иску могут присоединиться все покупатели проблемного товара просто отправив свои данные юридической компании, которая ведет дело, в обмен на часть выплат в случае победы. А коллективный иск с тысячами истцов — это уже не финансовые, а имиджевые потери. Поэтому лучше перебдеть и занизить заявленный ресурс.

Уголок стандартизации

К слову о стандартах. Существует Joint Electron Device Engineering Council, он же JEDEC, он же Сообщество Инженеров, специализирующихся в области электронных устройств, он же комитет инженерной стандартизации полупроводниковой продукции при Electronic Industries Alliance. Собственно, они как раз и пишут партитуру по данному вопросу, которой пользуется весь оркестр производителей, представители которых туда и входят — такой себе Уроборос.

Но посмотрим на документы. Существует платный стандарт ресурсного тестирования SDD по JEDEC — SOLID STATE DRIVE (SSD) REQUIREMENTS AND ENDURANCE TEST METHOD JESD218B.01 от июня 2016. Расположен он тут. Имеющие лишние 76 долларов могут поинтересоваться. Мы же обратимся к открытым источникам и там найдем выдержку из ревизии А этого стандарта, опубликованную с разрешения JEDEC Элвином Коксом (Alvin Cox), руководителем Seagate еще в 2011 году.

В тексте накопители делятся на классы: потребительский и корпоративный. Нас интересует первый. Предполагается, что потребительский твердотельный накопитель будет работать 8 часов в день при 40 градусах Цельсия. При этом хранить данные ему положено в течение года после отключения при 30 °C. Температура тоже очень критична! О ней начиная с 12 страницы по ссылке.

Важно понимать, что носитель соответствует требованию функционального отказа (FFR) в случае, если число неисправных носителей по итогу теста меньше заданного. Т.е. стандарт подразумевает, что в течение года отключенного хранения могут не проснуться 3 из 100 накопителей даже в идеальных условиях, а народ трет поштучно!

UBER тут не про такси. Это показатель невосстановимых битовых ошибок — Unrecoverable Bit Error Ratio (UBER) и он нормируется.

Учитывая эти показатели для каждого уровня предела доверия (допуск сбоев и ошибок) можно подсчитать минимально необходимое количество экземпляров носителей для тестирования. Детальней здесь, на 224 странице.

Указанное сильно намекает, что популярные тесты живучести не особо-то и показательны для реальной жизни и нуждаются в корректировке, но тогда пострадает кликбейт у авторов.

Т.е. важно не только сколько контроллер затолкает электронов по ячейкам при постоянном в смысле качественного питания токе. Важно сколько при этом произойдет ошибок, как это потом прочитается, сколько это все пролежит без питания, насколько это приемлемо для конкретной пользовательской ниши и т.п.

На этом фоне нетрудно заметить, что НЖМД даже самых первых поколений сегодня, вероятнее всего, после включения покажут целостные данные, когда-то записанные на них. Но на них в любом случае будут действовать последствия естественного размагничивания. Оно протекает с разной скоростью в зависимости от материалов и внешних условий. Можно условно принять, что таковое происходит со скоростью примерно 1% в год и лет через 50 хранения HDD без питания, возможно, будут потери данных. На практике эта цифра будет колебаться. Но ведь никто из нас не видел жесткие диски, которые бы не читались по старости — да, поэтому лет 20–30 хранения без сильных внешних агрессивных факторов срок вполне реальный и, возможно, далеко не предельный.

Т.е. что в SSD, что в HDD есть предельные сроки хранения данных без питания. Обусловлены они разными факторами, но итог будет один — когда-то данные читаться перестанут, если физические процессы, которые ответственны за их хранение, не будут поддерживаться в нужном состоянии. При работе современный контроллер твердотельного накопителя сам перезапишет данные внутри носителя, обновив их. В случае винчестера дефрагментация частично обновит содержимое. Где-то используется технология data scrubbing — например, в RAID-контроллерах и файловых системах Btrfs и ZFS. Но для активно эксплуатируемых носителей эти моменты не так актуальны — они будут заменены на новые задолго до того, как эти проблемы повлияют на результат работы, плюс существует защита данных дублированием, избыточностью, дублированием с избыточностью в RAID, бекапами в конце концов.

Справедливости ради надо заметить, что большинство «флешек» после года-двух лежания в столе нормально прочтутся, а внутри они ближайшие родственники твердотельных накопителей.

Но мы несколько отвлеклись.

На стадии проникновения твердотельных накопителей на памяти типа MLC стало очевидно, что НЖМД неумолимо движутся в прошлое. Это не значит, что совсем скоро их не останется в продаже, но ровно три оставшихся производителя намекают нам, что их использование будет весьма нишевым.

Снижение заявленного ресурса по сравнению с SLC-накопителями оказалось не таким уж страшным. На практике потребительские накопители скорее выйдут из строя по причине производственных дефектов, скачков напряжения и прочего, чем от протирания флэш-памяти — горы вторичных накопителей ранних серий из корпоративных парков Европы и eBay.com с вполне приличными данными SMART подтверждают этот тезис.

Объемы носителей, предлагаемые рынку, окончательно утвердили их как рекомендуемые к применению в качестве системного — 120 и 256 ГБ по адекватным ценам уже не выглядели совсем куцо в качестве системных, как это было с 32 и 64 гигабайтами. Стали доступны и куда большие объемы, но они для массмаркета были несколько дороговаты, но были. И энтузиасты могли попробовать все прелести, например, игры с SSD либо беспрецедентные возможности по скоростям работы с базами данных, массивами мелких файлов и прочим.

Скорости подросли, в массовых продуктах нашлось место многоканальности, буферам из DRAM и вполне современным контроллерам, которые перечеркивали прошлые проблемы использования твердотельных накопителей. Отдельные контроллеры даже успевали сжимать входящие данные на лету и до физической памяти они доходили в сжатом виде, на лету же разворачиваясь при движении в обратном направлении. Ценой было снижение производительности, а выигрышем — борьба с усилением записи. Помашем рукой SandForce и вспомним сжатие дисков в ОС Windows, синие файлы в проводнике и т.п.

Но взгляды у разных производителей на технологии, которые могут прижиться, были разными и обкатывали их традиционно на пользователях т.к. в ином случае поезд с надписью «рынок» можно было и не догнать.

Самое главное — цены. Они стали относительно приемлемы, а вынося за скобки корпоративный сегмент, заметим, что вторичный рынок укрепил мнение о возможности и нужности применения SSD даже в среде не особо богатых пользователей. Ситуацию с ценами некстати подпортил пик поставок на рынок носимой техники. Часть производимой памяти ушла именно туда. И это была заметная часть, что не позволяло сильно снижать цены. Наоборот — наличие почти ажиотажного спроса у азиатских производителей находилось в прямом противоречии с идеей снижения цен.

Напомним, что параллельно совершенствовались производственные мощности полупроводниковых гигантов, и техпроцесс потихоньку утончался. Это позволяло повысить в натуральном выражении выход годных чипов за единицу времени с единицы затрат, т.е. с одной кремниевой «вафли» стало можно нарезать больше чипов памяти при том же их объеме. Сам процесс можно посмотреть на видео ниже — от производителя к производителю отличаться особо он не будет, но общее представление о том, как же это производится, сформирует вполне неплохо. Заодно можно оценить уровень организации и затрат.

Здесь важно заметить, что при утончении процесса в общем случае можно ожидать падения надежности ячеек памяти, т.к. на физическом уровне все становится пропорционально сложнее контролировать. С этим призвана бороться прикладная математика в виде алгоритмов коррекции ошибок контроллером твердотельного накопителя. Сегодня это удается вполне неплохо и пользователь не сильно задумывается как все устроено внутри. Но сама тенденция от этого никуда не девается. Соответственно на характеристики конечного изделия влияют множество факторов и экономические здесь не сильно вторичнее технологических.

Твердотельные накопители на MLC-памяти пошли в массы: объёмисты, быстры, надежны, относительно приемлемы по цене.

Отдельно стоит отметить, что твердотельные накопители лишь по инерции выпускаются в форм-факторах типичных НЖМД. Под такие виды исполнения есть стандартизированные крепления и возможность легкого подключения — не более. Внутри большинство твердотельных накопителей хорошо, если занимают половину отведенного физического объема.

Новые же компьютеры могут в принципе-то и вообще не иметь возможности подключения физически отдельного накопителя и, особенно в портативной технике, носитель прямо распаивается на системной плате, экономя место и вес. Да, заменить его не получится, но по логике таких производителей замена будет вместе с устройством, т.е. это не проблема с учетом приличного ресурса такого накопителя. Вероятно, само изделие устареет до протирания памяти.

Здесь дам небольшую ремарку. В ноутбуке, где пишется этот текст, системным диском установлен обозначенный ранее Сrical BX100 256GB на МLC. Заявленный ресурс производителя — 72 ТБ, японец дошел почти до 3 ПТ (хотя это не показательно, но тем не менее). Windows 10 64-bit, а у меня 8 ГБ ОЗУ, при офисном сценарии работы с кучей браузеров с десятками вкладок, а это серьезная нагрузка на кэш браузеров мелкими записями, генерирует 3–5 ГБ записи в рабочий день, если BD-rip не увлекаться. Т.е. 72 терабайта я запишу за 14400 дней или примерно 40 лет. По японскому сценарию 3 ПТ или 3 000 000 гигабайт я запишу за 600 000 дней или 1 643 года.

Если таки увлекаться крупными записями и суточно в среднем писать раза в 2–3 больше, что в обычной жизни смоделировать без узкоспециализированных нагрузок непросто, то в первом случае это гарантированные производителем 15–20 лет и вполне респектабельные лет 500 по японскому сценарию.

С учетом того, что 72 ТБ производитель мне гарантирует, на практике будет не меньше, а, скорее всего, больше. С учетом того, что большие объемы носителей по понятным причинам имеют больший гарантированный ресурс — там банально больше ячеек — вопрос практического ресурса твердотельных носителей на MLC-памяти можно закрывать совсем. Так сделали все, кто умел считать и вопрос усиления записи, выбора куда поместить файл подкачки ОС и прочие окончательно утратили актуальность. Даже безымянные китайские поделки на восьмой категории отбраковки памяти именитых производителей нередко выхаживают больше заявленного ресурса. Что уж говорить о мейнстримовых гигантах.

К слову о любителях локальных объемных архивов — таковые будут вероятнее всего размещены на НЖМД. Если не в компьютере, то в NAS. Там большие скорости обычно не нужны, а объемы в пересчете на цену гигабайта хранения сегодня просто очень дешевы. И если вы боитесь облаков, то домашний рейд из HDD с избыточностью гарантированно сохранит архивы надолго и недорого. Вполне вероятно, что в этой или похожей нише, а так же в дата-центрах с относительно холодными данными, жить им еще долго, как продукту.

Но вернемся к твердотельным накопителям. Statista.com сообщает нам следующую информацию:

- В 2015 на рынок поставили 470 миллионов HDD и 105 миллионов твердотельных накопителей.

- В 2016 — 425 и 140 соответственно.

- В 2017 — 395 и 190.

Паритет будет достигнут ориентировочно в 2020 году и далее рыночная доля НЖМД начнет сокращаться, уступив первенство твердотельным накопителям.

TLC — не Toyota Land Cruiser, 2016

Следующий этап развития твердотельных накопителей внес некую сумятицу и неразбериху в терминологию. Техническая мысль подсказывала, что если в одной ячейке научиться распознавать и задавать больше отдельных уровней заряда, то можно на той же площади кремниевой заготовки вырастить бОльший рабочий объем итоговых накопителей при практически тех же затратах. Т.е. заработки будут больше при том же техпроцессе или издержки на тот же объем накопителя ниже, т.е. рождается главное конкурентное преимущество — ценовое. Идея не сказать, что была инновационной, она была известна давно и опытно разрабатывалась в рабочем порядке, но успех MLC накопителей ускорил НИОКР в этом направлении. В итоге технологию довели до серии и она была названа TLC (Triple Level Cell), т.е. в ячейке предлагалось различать 8 уровней заряда или 3 бита. Отсюда и слово Triple.

Неразбериха заключалась в том, что в глазах массового потребителя Multi Level Cell звучало круче, чем Triple Level Cell! Ведь маркетинг приучил потребителя, что «мульти» должно быть явно больше чем «три». Глубоко, конечно, мало кто разбирался. Главным критерием покупки для широких масс по сей день является цена и острота маркетингового соуса, но к маркетингу мы еще вернемся.

Не нужно было быть физиком, чтобы понять, что с технической точки зрения различать 8 уровней заряда в микроскопической ячейке труднее, чем 4 и тем более 2. Нагрузка при работе на материал будет жестче, износ быстрее, ошибок больше. А тут еще и техпроцесс собираются еще более утончить, усугубляя названное.

В итоге заявленный ресурс TLC-ячейки оказался еще меньше, чем у предыдущих технологий — 1000–3000 перезаписей. Несложно догадаться, что носитель небольшого физического объема выработает такой ресурс в качестве системного под нагрузкой быстрее предшественников. Покупатели с опаской отнеслись к новому классу продуктов и еще активнее начали интересоваться уже прочно зарекомендовавшими себя как надежными накопителями на технологии MLC.

Но TLC была дешевле, что являлось определяющим, особенно при массовых закупках, где один доллар на конечной стоимости уже очень большая разница. Да и контроллеры подтянулись — работа с ошибками была хорошо отлажена и в целом TLC-решения при относительно небольшой цене показали вполне неплохие результаты, как по скорости, так и по надежности. Правда, на розничном рынке понятие дорого-дешево в части твердотельных накопителей получилось несколько смазанным. Нередко разницы не было совсем, либо она была незначительна. Как в такой ситуации убедить покупателя, что брать надо TLC с меньшим ресурсом, чем MLC с большим? А никак не надо — со временем MLC должна была либо уйти в ниши рынка по относительно высокой цене, либо вообще могла быть вытеснена новыми технологиями как архаизм. Надежный такой, быстрый и недорого архаизм на «толстом» техпроцессе, который грозил пережить последователей.

Но мы помним, что заявленный производителем гарантированный ресурс и фактические предельные возможности — вещи разные в т.ч. юридически. И в технических спецификациях TLC-накопителей страшных цифр никто не увидел. Даже наоборот, Kingston SSDNow UV400 240GB, построенный на Toshiba 15-нм TLC NAND имел заявленный ресурс аж в 100 ТБ. Т.е. покупатель в табличке видел данный накопитель даже как более выносливый, чем приведенный выше пример на MLC. И тут маркетологи решили, что три — это тоже мульти-, а значит TLC можно вполне честно назвать 3-bit MLC! Сколько премии выдали за этот ход — история умалчивает, но 3-bit мало кого интересовали, зато MLC это MLC.

Т.е. мои 5 ГБ записи в день позволили бы этому накопителю на достаточно хорошем контроллере Marvell проработать с моей типичной нагрузкой примерно 55 лет. Это конечно один из лучших представителей платформы, но даже если усилить нагрузку и занизить ресурс, то лет 10 работы ему отведено.

В итоге надежность массовых накопителей на TLC оказалась вполне приемлемой для массового рынка и в конечном итоге зависела от применяемой логики и конкретного исполнения.

Итак, за относительно короткий промежуток времени твердотельные накопители, основанные на флэш-памяти (которая, как явление была придумана в середине 80-х), где данные задавались и считывались формированием и анализом уровня заряда в конкретной микроскопической ячейке, продвинулись в развитии достаточно серьезно, но для обывателя этот прогресс выглядит нелогичным. Ведь SLC-память на толстых техпроцессах выдерживала 100 000 циклов, MLC в зависимости от толщины процесса и контроллера уже переносила 3000–10000 заявленных циклов, а более продвинутая TLC — всего-то официально 1000+. Обратный какой-то прогресс. А в документах к конкретным носителям гарантированные циклы вообще измерялись трехзначными числами.

Но при этом росли скорости работы таких накопителей. В части работы с маленькими блоками они беспрецедентно недостижимы по сравнению с крутящимися дисками, надежность обеспечивается инновациями в контроллерах, а постепенное снижение цен несколько вытесняет технические подробности на периферию. Ну, ведь и правда, а кто задумывался какой накопитель у вас в смартфоне, какой у него ресурс, что там с износом на текущую дату и т.п.? А ведь там зачастую данные поважнее, чем в среднем по домашнему ПК и бекапов обычно-то и нет, нагрузка постоянная и условия работы не тепличные.

Но указанное было далеко не вершиной развития твердотельных накопителей.

Эра 3D

Достигнув, как казалось, разумного предела по количеству уровней заряда, производители решили посмотреть вверх и увеличить плотность продукта на выходе, формируя физически вертикальные структуры памяти. Nvmdurance нарисовали это для наглядности так:

Источник — NVMdurance.com

Обобщенно такие варианты начали называться с приставкой 3D: 3D MLC, 3D TLC, причем, вторая на рынке распространена сильно шире. Особыми усилиями в этой сфере отличились Samsung и Мicron. Количество слоев таких вертикальных структур выросло до 96 в 2018 году. Но эти технические детали не имеют особого значения для пользователя. Практически выносливость новых типов в части компоновки памяти оказалась на достаточном уровне, чтобы не забивать себе голову расчётом количества дней до планируемого выхода из строя накопителя. Отдельные экземпляры на 32 слойной 3D MLC памяти от Samsung в тестах на протирание до дыр показали просто фантастические результаты выносливости, уверенно перевалив за 7 ПТ при заявке производителя в 150 ТБ ресурса. Мы помним, что эти тесты на самом деле не показательны, но совсем игнорировать их тоже нельзя — такой выдающийся результат во многом намекает, что вопрос ресурса окончательно утратил актуальность в общем случае. Гарантированный пробег любой накопитель любого более-менее приличного бренда гарантированно отработает, а для массового потребителя этого, в общем, достаточно.

Условный ресурс 3D MLC в зависимости от слойности, техпроцесса и прочего можно оценить от 5000 до 40000 перезаписей. Приведенный выше пример протирания до дыр показал почти 54000 (!) условных циклов.

Для 3D TLC это, опять же условно, будет 1000–3000 циклов, но на фоне возрастающих объемов самих носителей это количество записывать придется достаточно долго.

Поэтому вопрос ресурса твердотельных накопителей пока прикроем — он достаточен для массового рынка и вернемся немного к аппаратным реализациям в части интерфейса подключения.

SATA, M.2, NVMe и PCI-E

Как уже упоминалось выше, твердотельные накопители унаследовали форм-фактор HDD. Единичные были даже с IDE-интерфейсом, например от Transcend. Отдельные были воплощены даже в 3,5-дюймовых корпусах (Imation 3000 Mtron), но большинство в 2,5″. Места хватало и там и там, но таким образом была достигнута совместимость с основным объемом компьютерного парка — к моменту массового выхода SSD на рынок систем без интерфейса SATA уже практически не производилось.

Известны три основные ревизии, именуемые в быту SATA1, SATA2 и SATA3. Для пользователя разница в основном в пропускной способности — 150, 300 и 600 мегабайт в секунду соответственно. Есть и иные реализации, но мы сконцентрируемся на указанных.

Первая ревизия родилась аж в 2003, вторая через год, а третья — в 2008. Последняя встречается почти в любом современном компьютере, реже встречается вторая. В общем случае есть обратная совместимость.

Важно понять, что даже первая ревизия SATA, по сути, не была узким местом т.к. тогдашние накопители не могли достичь предела скорости передачи данных в реальных сценариях, кроме прямого чтения или записи большого массива данных, что актуально далеко не для всех пользователей.

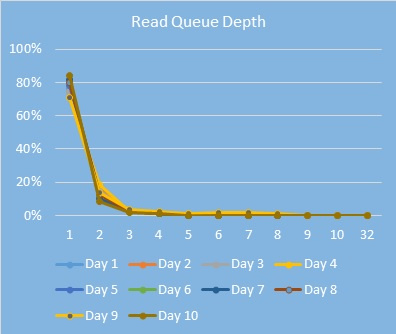

Исследования Intel внутри компании показывают, что в офисной жизни такие нагрузки крайняя редкость. Дома — тоже. Ну не копируете вы целыми днями большие объемы последовательно туда-сюда. Т.е. такие пользовательские сценарии, конечно, есть, но они в подавляющем меньшинстве и пользователи там озадачены совсем иными проблемами.

Источник — Habr.com

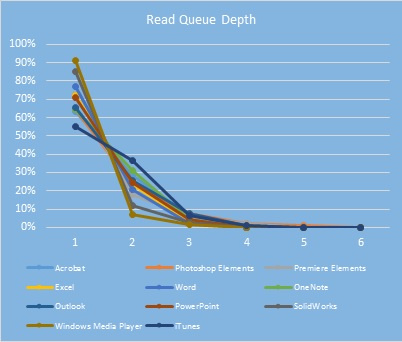

Основным типом нагрузки в SOHO является как раз работа с 4K-блоками и глубиной запроса 1, реже 2, а более — еще реже.

В этом прекрасном сценарии даже самые современные жесткие диски могут показать эффективную скорость чтения-записи хорошо если в 1 мегабайт в секунду. Один! На практике будет еще меньше — 0,6 МБ/с примерно. Т.е. вся основная нагрузка на накопительную подсистему в случае HDD не способна выбрать даже 1% пропускной способности SATA1. Любой читатель может проверить это, запустив популярный тест на своем системном винчестере.

При этом в эту скорость упирается вся отзывчивость интерфейса — память и процессор ждут медленный диск. В итоге пользователь оценивает взаимодействие с интерфейсом термином «тормозит».

Не так страшно подождать запись учебного фильма на скорости 150 мегабайт в секунду, как постоянно ждать фризы интерфейса в привычном ПО. И переход на SATA3 в случае HDD увеличит разве что скорость последовательных чтения-записи до физических пределов носителя, но скорость работы с 4К с глубиной запроса в 1 не изменится вообще никак, т.е. интерфейс будет продолжать «подтормаживать». Сделать с этим почти ничего нельзя. Почти.

В части записи производители всегда пытались оснастить НЖМД буфером из DRAM, чтобы создать быстрого посредника между ОС и медленным накопителем. Но такие буферы обычно небольшие и никак не позволяют улучшить ситуацию с первым чтением данных после загрузки.

Были попытки улучшить ситуацию технологией ReadyBoost в ОС Windows, но нужно было искать быстрый носитель для поддержки HDD. Таковой был найден в виде Intel Turbo Memory, но сегодня его даже в музеях 2,5 экземпляра. Опять кольцевая.

Отдельные энтузиасты, имея большие объемы ОЗУ, благодаря кэшированию ОС после первичного медленного запуска тяжелого ПО могли длительно не упираться в скорость жесткого диска, т.к. работа с данными крутилась в ОЗУ и подкачка была не нужна, как и дополнительное чтение. Но это узкий случай.

Еще раз — большинство реальных сценариев нагрузки на дисковую подсистему не способны выбрать даже ширину SATA1, не говоря о третьей ревизии.

Но зачем тут об этом?

Дело в том, что типичный SSD выполнен в формате 2,5-дюймового носителя с SATA-интерфейсом, который можно прямо подключать почти в любую систему. Фото типичного SSD было в самом начале.

Ключевой особенностью SSD является скорость работы с разными типами нагрузки. Линейные скорости SATA SSD действительно упираются в ширину интерфейса. 500–560 мегабайт в секунду линейного чтения-записи — реальность. Но реальность эта востребована, как мы помним, нечасто или даже вообще редко. Линейная работа с накопителем в подавляющем большинстве случаев не является типичной нагрузкой. Но цифры красивые. Причем это далеко не предел, как мы увидим ниже.

В случае же с 4К нагрузкой и глубиной запроса в 1–2 типичные SATA SSD показывают скорость в 15–20–40 мегабайт в секунду. А вот тут уже самое время быть повнимательней. Это самая основная и типовая нагрузка, которая сегодня бывает в современных ОС и SSD, позволяет ускорить работу в этом сегменте примерно в 40–80 раз! В реальности это очень сильно возросшая скорость загрузки системы, программ, отзывчивости интерфейсов, скорость работы браузеров т.к. они очень любят дисковый кэш и т.п.

Именно поэтому простая замена старого НЖМД в типичном немолодом ноутбуке дает такие чудесные субъективные результаты — тысячи видео об этом на Youtube.com.

Заметим, что в части типичной нагрузки даже современные SSD не способны выбрать ширину пропускания даже SATA1 в 150 мегабайт в секунду. Однако все же есть пользователи, которым нужны линейные скорости и современные SSD здесь могут выступить совершенно обескураживающе быстро. Но вот незадача — SATA3 пропустит только 600 мегабайт, а лучшие экземпляры твердотельных накопителей давно перешагнули этот рубеж благодаря многоканальности, новым технологиям, контроллерам и прочему. Что делать?

Расширять рамки. В 2013 году появились первые NVMe SSD в формате М.2, работающие через PCI Express, а это уже гигабайты пропускной способности в секунду.

Так, например, Samsung 960 EVO способен линейно читать со скоростью 3200 мегабайт в секунду, а записывать — 1500! Цифры ориентировочные — нас интересуют именно порядки.

Трудно представить, где массово могут быть утилизированы такие скорости на бытовом уровне сегодня, но есть у этого передового примера и обратная сторона — в режиме случайного чтения 4К-блоков скорость снижается примерно до 40–50 мегабайт в секунду. Т.е. в реальных задачах опять не выбрана даже ширина SATA1.

На практике это означает, что каких-то прорывных преимуществ пользователь такого передового накопителя по сравнению с менее передовым, даже в ряде случаев на SATA3-интерфейсе, накопителем не получит. Бытовые задачи как-то заметно отличаться в скорости проведения не будут, т.к. все они лежат в зоне 4К-операций с малыми глубинами запросов. Если уж совсем по бытовому, то игры на Samsung 960 EVO не будут быстрее, чем на 850 EVO или 860 EVO, т.к. у последних 4К-скорости примерно 40 и 50 МБ/с соответственно.

Конечно, профессиональные пользователи выберут то, что им подходит под конкретные задачи, но показанное иллюстрирует, что выбор не очевиден. Не всегда соблюдается «дороже-лучше-быстрее».

Так же хотелось бы отметить, что, как и жесткие диски, некоторые SSD не лишены буфера из DRAM. Это позволяет поддержать накопитель в ситуациях, когда объемы обмена небольшие и их можно провести через буфер с отложенной записью в NAND. В общем случае, чем больше такой буфер, тем лучше. Особенно он поможет слабеньким реализациям SSD на относительно медленной памяти и со слабыми контроллерами, но даже такие будут всегда быстрее любых НЖМД. Даже в его отсутствии буфер может создаваться программно в режиме SLC из имеющегося массива на носителе. Решение обходное, но рабочее.

Тут надо отметить, что с распространением флэш-памяти ее пытались пристраивать буфером в НЖМД. Получались так называемые гибриды SSDHDD, SSHDD или как фантазия маркетологов решит назвать это. Получалось очень так себе. Размер буфера из флэш был маленьким, настраивать работу его логики не разрешалось, а штатная прошивка ничем выдающимся обычно не выделялась. В массы такие решения не пошли, хотя могли бы. Об этом мы еще поговорим. В любом случае именно в такой гибридной аппаратной реализации они были вообще не нужны никому и никогда. Зато в нишу пришли разработчики ПО для этих целей, которое позволяло создавать связку из HDD и кэша на любом SSD. Получалось куда лучше. Например, PrimoCache крайне эффективно умеет кэшировать как запись так и чтение на медленный НЖМД через ОЗУ и любой SSD — подойдет даже самый маленький гигабайт на 16. Эффект будет сразу и заметный.

Так что покупать?

Возвращаясь в начало трактата отметим, что выбор SSD методом «сортировать по возрастанию цены» в интернет-магазине не является таким уж провальным — если вы не знаете, что именно вам надо и почему, но купить все же хочется, то такой подход в общем-то решит поставленную задачу. Любой, абсолютно любой SSD сегодня будет отличным решением для улучшения опыта работы с повседневными задачами. Даже самые слабые из них покажут примерно 15–20 мегабайт в секунду скорости чтения 4К-блоков, что и является основной пользовательской нагрузкой. Можно только посоветовать выбирать модель с DRAM-буфером т.к. у самых-самых дешевых его обычно нет. Но зато может быть SLC-кэширование, которое призвано сгладить углы — из массива памяти выделяется часть и работает в режиме SLC c соответствующей неплохой скоростью. В зависимости от продвинутости контроллера конкретного носителя размер такого кэша может быть как фиксированным, так и динамическим. Работает это вполне неплохо, но важно понимать, что за пределами размера кэша скорости упадут. Но если у вас нет объемов, которые выходят за рамки такого кэша, то падения скорости вы можете не заметить, т.к. не попадете в условия, когда оно проявится. Ну и объем подбирать стоит под реальные задачи, но с падением цен на твердотельные накопители сегодня вряд ли имеет смысл рассматривать что-то ниже 256 гигабайт в общем случае.

Но, one more thing, как говорят любители фруктов

История с SSD имеет два поворота, которые я решил вынести в отдельную часть материала.

Как мы узнали, эволюция выносливости твердотельных накопителей в части количества перезаписей ячеек идет задом наперед — от 100 тыс. в SLC до 1000 в TLC. Инженеры и маркетологи сильно постарались загримировать этот нюанс. И хотя он обусловлен технически — приятного в нем нет ничего. Тем не менее, особо этот показатель на реальную эксплуатацию твердотельных накопителей сегодня не влияет — реальный ресурс позволяет говорить о том, что носитель «заржавеет» раньше, чем износится.

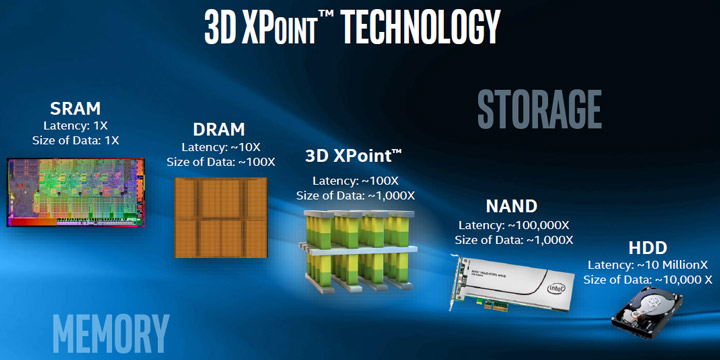

На этом фоне Intel и Micron в 2015-м представляют миру новую память — 3DXpoint и продукт с рыночным названием Optane на ее основе. Внутренние детали технологи не важны. Важно то, что это лучшее, что случалось в сфере накопителей и хранения: высочайшие скорости при минимальных задержках.

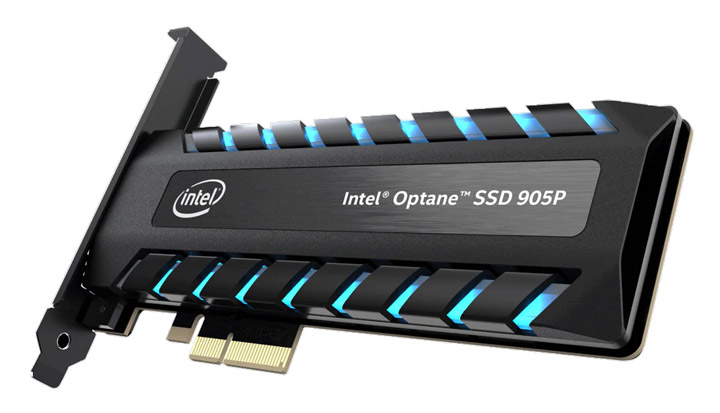

Выдающимся представителем можно назвать Optane SSD 905P.

Устройство подключается через слот PCI-E (этот класс я умышленно пропустил выше) и способно к линейной записи-чтению на скорости примерно 2500–2700 мегабайт в секунду. Но революционность не в этом — работа с 4К-блоками и глубиной запросов 1 происходит со скоростью около 300 мегабайт в секунду. Это почти фантастика на сегодня, ничего из существующего и рядом не стояло по этому показателю! Прекрасный результат. Цена тоже поражает воображение и надеяться на то, что скоро это станет мейнстримом, не приходится. При этом совершенно никаких вопросов по ресурсу. Даже заявленный покрывает практически все возможные потребности — для терабайтной модели это 17520 ТБ! Т.е. только официально заявлено 17 520 перезаписей ячеек.

Однако замечательное решение Intel таки решила продавать в розницу, но сначала NVMе-модулями по 16 и 32 ГБ для … кэширования медленных жестких дисков в системах, на базе своих процессоров и логики.

Предполагалось, что драйвер перенесет часто используемые данные на такой маленький кэш-носитель и они будут читаться с него с поразительной скоростью. Запись тоже думалось осуществлять транзитом. Но все это оказалось невостребованно, т.к. те, кто мог за это заплатить, изначально устанавливали системным диском твердотельный накопитель и НЖМД имели в системе, в лучшем случае, под хранение холодных данных. Нечто подобное предлагает и AMD для кэширования HDD любыми твердотельными накопителями, но особой популярностью решение тоже не пользуется, ввиду того, что обе концепции опираются на новое дороге железо производителей, покупатели которого НЖМД как системными дисками ожидаемо не интересуются. Про PrimoCache и аналоги написано выше.

Казалось бы, вот он недостижимый конкурентами пик производительности, осталось только немного снизить цены. Так и вспоминается незабвенное — «Еще 65535 ведер и золотой ключик у нас в кармане» (с). Действительно, дотянуться до Optane и постоять рядом в реальных задачах может только Samsung 983 ZET на 64-слойной 64-Гбит SLC 3D V-NAND. Но это очень, очень дорого, примерно 2300 долларов за терабайт в розницу, т.е. для обычных людей в основном на картинках, хотя узкие профессионалы такое могут купить под конкретные высокооплачиваемые задачи.

Будущее рядом, говорили они, и скоро пойдет в розницу за адекватные деньги, повторяли они.

А в это время айсберг…

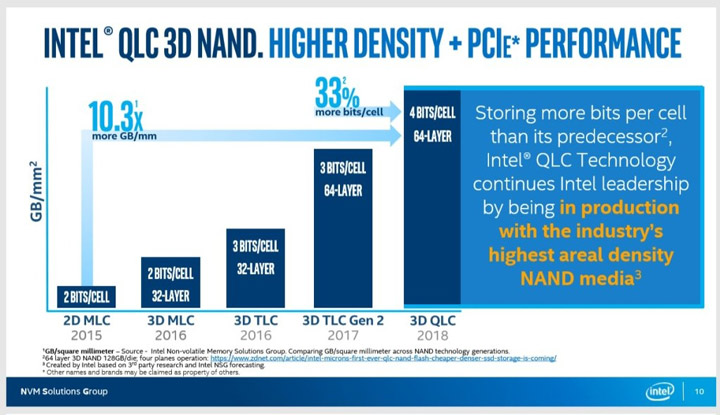

Второй поворот история исполнила буквально недавно — летом 2018 было объявлено о передаче в производство и очень быстро таки произведены первые ласточки накопителей на … QLC-памяти.

Потребитель только отошел от удивления падению ресурса в TLC, как ему предлагают уже 4-х ячеечную QLC. Приведу известную картинку.

16 разных уровней заряда и непонятные перспективы по скорости и ресурсу. Естественно сетевое сообщество разразилось шутками про полуразовые накопители и прочими колкостями, но так ли все плохо на сомом деле?

Сперва необходимо вспомнить, что при переходе к трёхъячеечной памяти фактически возросла плотность, и на той же пластине можно было получить больше гигабайт на выходе. Т.е., или заработать больше, или цену опустить для завоевания части рынка, но с ресурсом будет хуже. Здесь картина похожая, но технически сложнее.

И одной из первых в новой нише отметилась компания Samsung SATA-изделием 860 QVO на QLC 3D V-NAND. Платформа там была типичная — на терабайт объема гигабайт буфера из LPDDR4, максимальные линейные скорости в ширину SATA3 примерно и 360 терабайт гарантированной записи. Цена, правда, на уровне известных скоростями и надежностью конкурентов. С учетом того, что QLC должна была быть заведомо относительно медленной, производитель сообщил, что на терабайтном носителе 6 гигабайт будут работать в режиме статического SLC, т.е. быстрого кэша, и 36 — динамического. Итого 42 ГБ кэша в быстром режиме. Как это все должно отражаться на ресурсе — вопрос открытый, но 360 терабайт гарантировали, а это лично для меня почти 200 лет типично ежедневной работы.

Забегая вперед скажу, что тесты показали прямую линейную запись в QLC для 1 терабайтного носителя на скорости около 75 мегабайт в секунду. Вроде фиаско, но не совсем. Во-первых, ввиду многоканальности более объемные варианты будут быстрее. Так 2 терабайтная модель будет в 2 раза быстрее, но это не решит проблему т.к. такие линейные скорости давно по зубам обычным НЖМД, а 2 терабайта даже QLC дешевыми быть не обещают.

На самом же деле встретиться лицом к лицу с такой скоростью практически не получится — быстрый кэш в режиме SLC (именно в режиме, той, самой первой SLC, здесь, конечно же, нет и в помине) примет на себя поток данных в ширину интерфейса. Такового 42 ГБ. Т.е. скорость сильно упадет только на 43-м гигабайте записи подряд. Я такие проекты уже и не помню, когда ходом записывал, но я ведь не показатель, а те, кто таки так записывает — QLC не интересуется. В общем, разовые тормоза при записи никого особо не огорчат — до них пойди еще доберись.

Далее, когда нагрузка упадет, контроллер перенесет из SLC-кэша данные в QLC-память. Фоново и незаметно. Правда, потратив немного и так небольшого ресурса QLC — здесь о ресурсе стоит вспомнить чисто академически. Запись, по сути, получится двойной, а, вероятно, в силу технологии — и поболее, чем двойной. Последовательное чтение идет в ширину SATA3, что мы отмечаем чисто информационно.

А вот случайное чтение 4К всего 15 мегабайт в секунду, запись — 123,2 МБ/с. А вот тут уже перекос совсем не очень. В общем, решение получается слабое в самой важной точке — случайном чтении 4К, т.е. при обычной повседневной нагрузке. В остальном Samsung вполне конструктивно реализовал QLC, но кому это надо по цене конкурентов, которые куда лучше выглядят за цену этого накопителя? Причем конкурентов от Samsung же и на TLC, которые в дисциплине повседневной нагрузки покажу результат лучше раза в два с половиной?

Для ответа надо бы увидеть конкурентов на QLC. Может, мы что-то поняли не так? И такие очень быстро нашлись в лице Intel 660p и Сrucial P1, правда в виде NVMe. Intel на 1 терабайт носителя предлагает 200 терабайт ресурса записи.

К слову, Intel в данном случае блеснула маркетингом и заявила о лидирующем в отрасли количестве бит на ячейку.

Т.е. QLC это такая победа. Видимо над здравым смыслом, но линейные скорости записи в рамках SLC-кэша (решение аналогичное вышеописанному) и чтения вполне себе «NVMешные» — около 1000 мб в секунду. А вот случайное чтение 4К и запись, что является обычной нагрузкой, примерно 30 и 180 МБ в секунду. Т.е. на уровне многих конкурентов, хотя сегодня такими цифрами никого в хорошем смысле не удивить, особенно на фоне лидера по количеству бит на ячейку. Сrucial P1 ожидаемо концептуально похож. Маркетологи такие маркетологи.

В итоге решения на QLC в общем хоть и жизнеспособны, но их стоимость могла бы быть и пониже. Иначе разбирающийся покупатель обойдет их стороной, а покупающий по цене не обратит внимания.

Немного скрепя сердце можно сказать, что выбирать по цене можно смело продолжать — сильно ошибиться не получится, правда Samsung здесь выглядит не молодцом и ударил в штангу.

Но зачем так детально было рассматривать QLC-накопители в контексте данного материала?

Новые гибриды и танцы на граблях

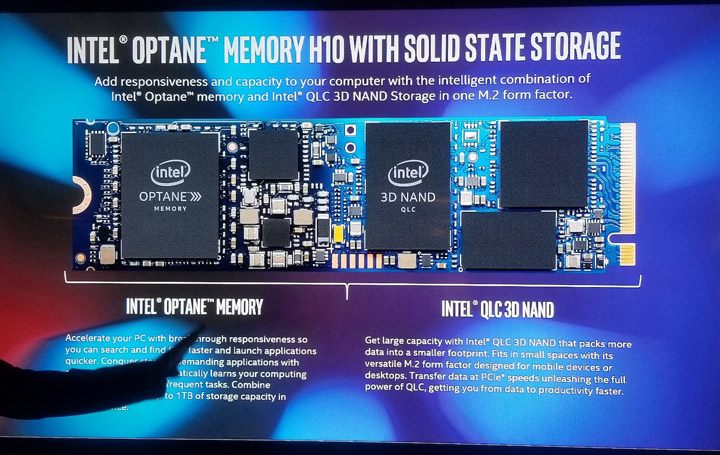

Ответ кроется в завершающем аккорде — в январе компания Intel представила Optane Memory H10.

Это М.2-гибрид из массива памяти QLC, которая проваливается по случайному чтению 4К, а именно в повседневной нагрузке, но с кэшем из… молниеносного Optane. Варианты будут разными. Интересно выглядит 32 ГБ Optane + 1 ТБ QLC. Как это будет работать несложно спрогнозировать заранее — данные по критерию востребованности будут распределяться в быструю и медленную память, плюс транзитный кэш: самое востребованное будет мгновенно читаться из Optane, остальное — уже из QLC. Как видим, Intel заранее подстраховывает слабые места самого медленного сегодня типа твердотельной памяти самым быстрым решением. Гибрид прямо скажем, странный и нишевой. Дешевым он не будет, а дорогим, опять же, мало кому интересен, но его можно будет предлагать в комплекте с дефицитными ныне процессорами производителям ноутбуков — нет покупок Н10, нет и процессоров. Единственный плюс в том, что данное решение сегодня почти что самое технологичное на рынке и достойно академического внимания, ведь таких мутантов даже в кино не показывают. Этим кадром мы символично завершим серию инфографики — от магнитофона ATARI до Optane.

Что же в итоге?

SSD прочно и бесповоротно вошли в рынок, они быстры, относительно надежны и сегодня уже совершенно приемлемы по цене, вероятнее всего будут системными в большинстве нового парка на рынке и развиваются, хоть и специфически. Наряду с преимуществами, главным из которых является таки скорость, они, ввиду используемых технологических решений, одновременно несут риски относительно неожиданного выхода из строя с низкими шансами восстановления информации и плохими перспективами сохранения данных в отключенном состоянии уже в среднесрочном периоде. При этом указанные риски, для обеспечения использования преимуществ, подлежат урегулированию вполне доступными инструментами — резервными копиями, разными видами RAID и т.п. Важно принимать риски осознанно, выполнять несложный набор действий для минимизации неблагоприятных последствий и все будет хорошо, быстро и инновационно.

Н.Ж.М.Д – все?

Не совсем. Поставки SSD растут и прогресс останавливать смысла особого нет, но Н.Ж.М.Д. в долгосрочной перспективе примерно настолько же надежней, насколько и медленней твердотельных накопителей. Свои ниши они найдут, но системными в массе быть со временем перестанут. Это произойдет, конечно же, не завтра — сегодняшний тренд на падение цен всегда можно притормозить снижением поставок и производства, пожарами, наводнениями и даже землетрясениями if you understand what I mean. Поэтому доступны они будут еще весьма долго для разных сфер потребления, а технологии, позволяющие несколько продлить им жизнь и поднять скорости без ущерба надёжности уже давно подвезли и частный пример в виде ReadyBoost всем известен, но есть и куда более современные, но привязанные к железу, такие как Optane-кэширование, AMD Storemi, а так же вполне конкурентоспособные независимые продукты для работы на любом железе вообще, в т.ч. и серверном, такие как PrimoCache от Romex Software. Так что списывать HDD со счетов, в т.ч. и системных, еще рановато и об этом мы еще поговорим.

И что с протирателями флэша до дыр — они занимаются тратой времени на кликбейт без прикладного результата?

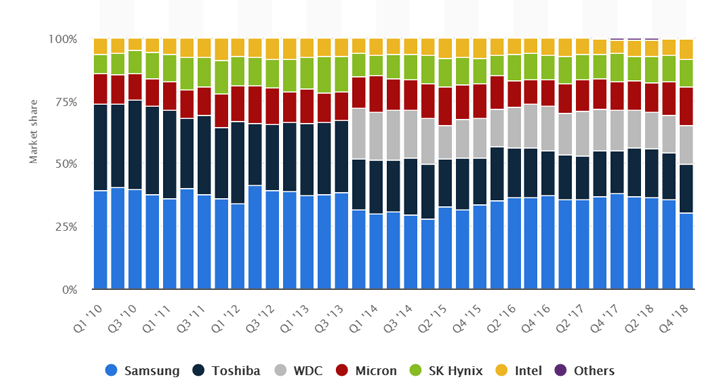

Не совсем так. Выше мы прочитали про видение этого вопроса в плоскости стандартов. И с этих позиций толку в марафонах немного. Но используемые технологии постоянно усложняются, а техпроцессы утончаются. Вводятся новые подходы во внутренней логике работы контроллеров, типа многократных попыток чтения с разными электрическими характеристиками — авось при каком-то напряжении ошибок не будет. На этом фоне протиратели достигли одного неочевидного на первый взгляд, но подтвержденного статистически достоверно, вывода — при постоянном хорошем питании твердотельные накопители уверенно превосходят паспортные показатели. Но какой от этого толк? Его мы, скорее всего, увидим уже в будущих сериях SSD. Возможно даже в каких-то реализациях QLC-технологий или позже, т.к. количество доступных перепрограммирований ячеек с последующим уверенным чтением, как мы видим, неуклонно падает по конкретно-физическим причинам. Это, скорее всего, будет снабжение накопителей оффлайн-питанием, т.е. аккумуляторами, чтобы хотя бы между включениями рабочей станции такой накопитель не голодал. Но это только предположение. Правда, основанное на статистике. Но так уже и до i-ram недалеко — там что-то похожее уже было. Но все это потом, а в данный момент рынок флэш-памяти NAND, на которой и построены твердотельные напотели, выглядит вот так, т.е. почти олигопольно, что не может не намекать на перспективы динамики цен на востребованный продукт.

Lead-out

Спасибо дочитавшим до конца. Свои отзывы и предложения прошу оставлять в комментариях. Возможно, я что-то не осветил в стремлении к лапидарности или кто-то с чем-то не согласен, и мы вместе повысим образовательный уровень наш и тех, кто эту статью найдет в поиске в будущем.