Компания Intel выпустила набор инструментов Computer Graphics Visual Quality Metric (CGVQM) для оценки качества изображения в видеоиграх. Это самый точный автоматизированный современный метод анализа изображения, который позволяет выявлять артефакты изображения и их причину. Изначально технологию создавали для анализа артефактов сжатия, чтобы понять уровень искажений при передаче потокового видео, например, на YouTube и Netflix. Но постепенно ее превратили в более точный набор инструментов для анализа графического контента. Ранее основным критерием оценки было пользовательское человеческое восприятие. А CGVQM предлагает более точный автоматизированный метод с точными метриками.

CGVQM помогает выявить разные искажения и выдает точные метрики по интерпретируемой шкале. Также указывает не только отдельные показатели качества, но и возможные причины визуальных ошибок (искажений). Хорошо работает с разным типом контента — от стилизованных фэнтезийных сред до фотореалистичных открытых миров, с учетом разных методов рендеринга.

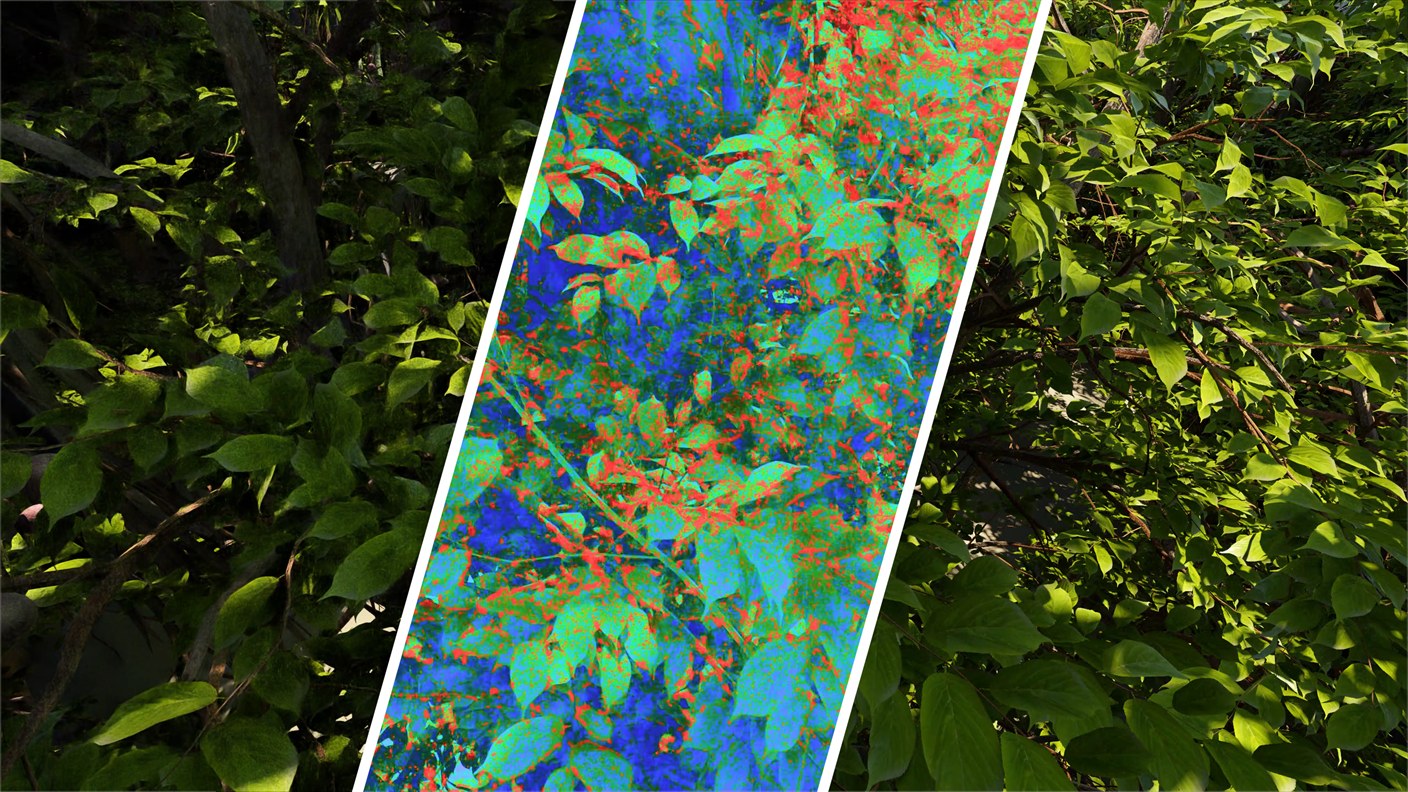

Анализ проводится на основе 80 коротких видеофрагментов с разным спектром визуальных артефактов при использовании разных методов рендеринга, включая нейронный суперсемплинг (DLSS, XeSS), трассировку пути, нейронное шумоподавление, интерполяция кадров и другое. Чтобы понять, как артефакты влияют на человеческое восприятие, было проведено субъективное исследование с участием 20 участников, каждый из которых оценил воспринимаемое качество искажённых видео по сравнению с эталонными версиями. Далее используя эти наборы данных на основе нейросети 3D ResNet-18 была разработана система метрик. Этот метод выдает глобальную оценку качества и попиксельную карту ошибок.

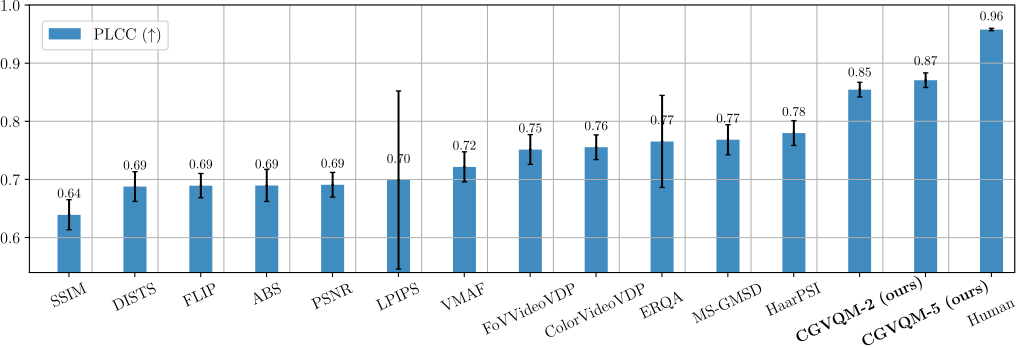

CGVQM превосходит все современные метрики по прогнозированию человеческих оценок. Конечной целью является более точный анализ рендеринга для настройки движка и выбора оптимального баланса между качеством и производительностью. То есть это полезный инструмент для разработчиков. Это шаг к более интеллектуальному методу оценки качества графики в будущем.

Источник:

Intel